检索增强生成 (RAG) 在大型语言模型 (LLM) 领域标志着一次变革性的进步。它将变压器架构的生成能力与动态信息检索相结合。

这种集成允许 LLM 在文本生成的过程中访问和整合相关的外部知识,从而产生更准确、上下文相关且事实一致的输出。

从早期的基于规则的系统发展到像 BERT 和 GPT-3 这样的复杂神经模型,为 RAG 铺平了道路,解决了静态参数内存的限制问题。此外,多模态 RAG 的出现通过整合图像、音频和视频等不同数据类型,进一步扩展了这些功能。这增强了生成内容的丰富性和相关性。

这种范式转变不仅提高了 LLM 输出的准确性和可解释性,还支持了各个领域内的创新应用。

我们将介绍的内容如下:

- 第一章. RAG 简介

– 1.1 RAG 是什么?概述

– 1.2 RAG 如何解决复杂问题 - 第2章 技术基础

– 2.1 从神经LM转向RAG

– 2.2 理解RAG的内存:参数化与非参数化

– 2.3 多模态RAG:整合多种数据类型 - 第3章 核心机制

– 3.1 RAG中信息检索和生成的结合力量

– 3.2 检索器和生成器的集成策略 - 第4章 应用和用例

– 4.1 RAG在工作中的应用:从问答到创意写作

– 4.2 RAG适用于低资源语言:扩展覆盖范围和能力 - 第5章. 优化技术

– 5.1 用于优化RAG系统的先进检索技术 - 第6章. 挑战与创新

– 6.1 RAG目前的挑战和未来的方向

– 6.2 RAG系统的硬件加速和高效部署 - 第7章. 总结性思考

– 7.1 RAG的未来:结论与反思

先决条件

要参与关于大型语言模型(如检索增强生成RAG)的内容,有两个基本先决条件是:

- 机器学习基础:理解基本的机器学习概念和算法至关重要,尤其是它们如何适用于神经网络架构。

- 自然语言处理 (NLP):掌握NLP技术,包括文本预处理、标记化和使用嵌入,对于处理语言模型至关重要。

第一章:RAG简介

检索增强生成 (RAG) 通过结合信息检索和生成模型,革新了自然语言处理。RAG 动态访问外部知识,提升生成文本的准确性和相关性。

本章探讨 RAG 的机制、优势和挑战。我们深入研究检索技术、与生成模型的整合,以及对各种应用的影响。

RAG 缓解了幻觉,结合了最新信息,并解决了复杂问题。我们还讨论了高效检索和伦理考虑等挑战。本章提供了对 RAG 在自然语言处理中变革潜力的全面理解。

1.1 什么是 RAG? 概述

检索增强生成 (RAG) 代表了自然语言处理中的一种范式转变,完美结合了信息检索和生成语言模型的优势。RAG 系统利用外部知识源,提升生成文本的准确性、相关性和连贯性,解决了传统语言模型中纯参数记忆的局限性。(Lewis 等人, 2020)

通过在生成过程中动态地检索和整合相关信息,RAG使得在各种应用中(从问答和对话系统到摘要和创意写作)能够产生更有上下文依据和事实一致的输出。(Petroni et al., 2021)

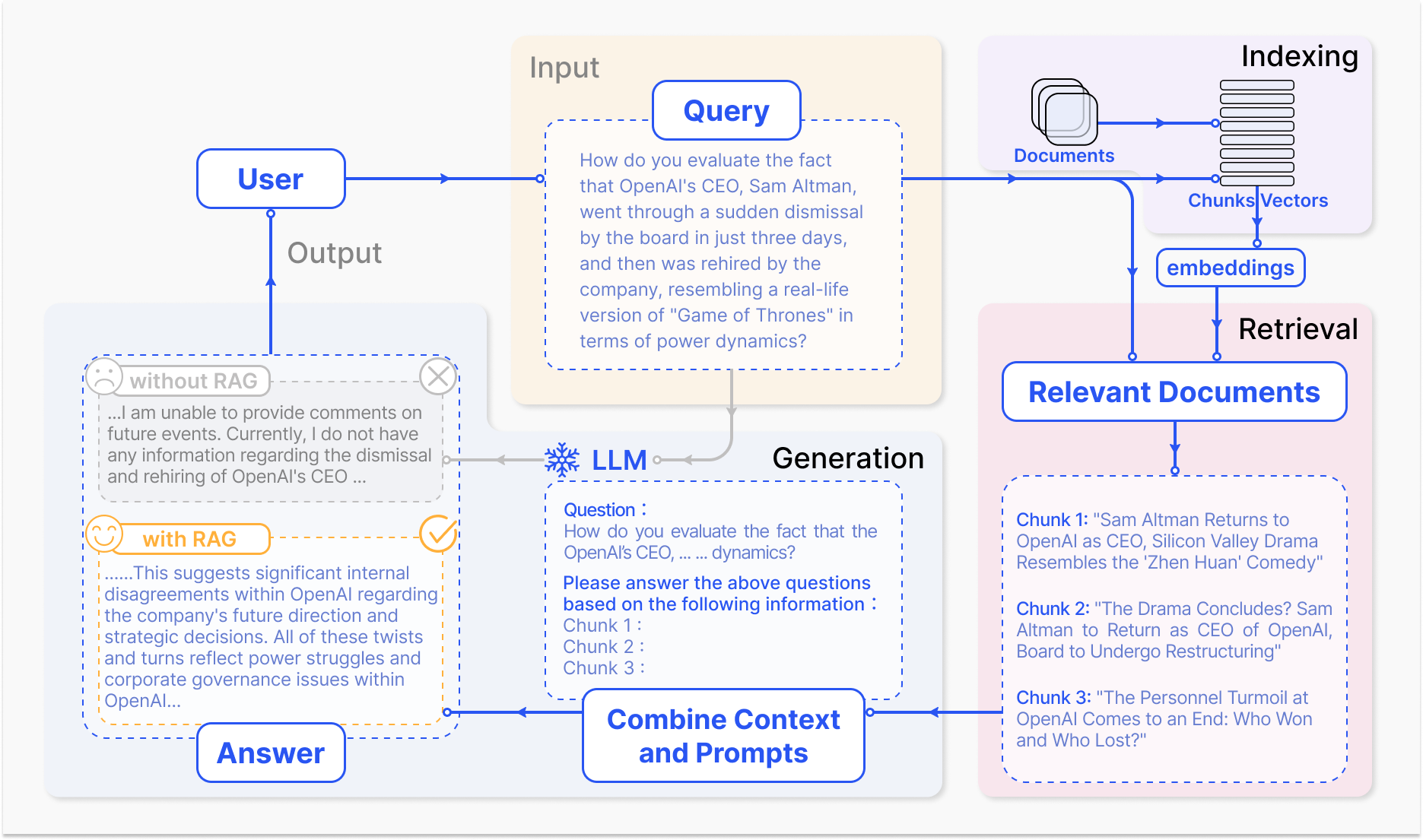

RAG系统如何运作 – arxiv.org

RAG的核心机制包括两个主要组件:检索和生成。

检索组件有效地搜索大量知识库,以根据输入查询或上下文识别最相关的信息。使用了诸如稀疏检索(利用倒排索引和基于词的匹配)和密集检索(采用密集向量表示和语义相似性)等技术来优化检索过程。(Karpukhin et al., 2020)

然后将检索到的信息整合到生成模型中,通常是一个像GPT或T5这样的大型语言模型,该模型合成相关内容,产生连贯流畅的响应。(Izacard & Grave, 2021)

RAG中检索和生成的整合为传统语言模型带来了几个优势。通过将生成的文本与外部知识联系起来,RAG显著降低了虚构或事实不准确输出的发生率。(Shuster等人,2021)

RAG还允许您整合最新的信息,确保生成的回应反映出给定领域最新的知识和进展。(Lewis等人,2020)这种适应性在诸如医疗保健、金融和科学研究等领域尤为重要,在这些领域,信息的准确性和及时性至关重要。(Petroni等人,2021)

但是,RAG系统的开发和部署也带来了显著的挑战。从大规模知识库中高效检索、减轻虚构以及整合多样化的数据模态等技术难题需要解决。(Izacard & Grave,2021)

此外,确保无偏见、公平的信息检索和生成等伦理考量对于RAG系统的负责任部署至关重要。(Bender等人,2021)开发全面的评估指标和框架,捕捉检索准确性与生成质量之间的相互影响,对于评估RAG系统的有效性至关重要。(Lewis等人,2020)

随着RAG领域的不断发展,未来的研究方向集中在优化检索过程、扩展多模态能力、开发模块化架构以及建立健壮的评估框架。(Izacard & Grave,2021)这些进步将提高RAG系统的效率、准确性和适应性,为自然语言处理领域更智能、多功能的应用铺平道路。

以下是一个基本的Python代码示例,演示了使用流行库LangChain和FAISS的Retrieval Augmented Generation (RAG)设置:

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS

from langchain.document_loaders import TextLoader

from langchain.chains import RetrievalQA

from langchain.llms import OpenAI

# 1. 加载和嵌入文档

loader = TextLoader('your_documents.txt') # 用你的文档来源替换

documents = loader.load()

embeddings = OpenAIEmbeddings()

vectorstore = FAISS.from_documents(documents, embeddings)

# 2. 检索相关文档

def retrieve_docs(query):

return vectorstore.similarity_search(query)

# 3. 设置RAG链

llm = OpenAI(temperature=0.1) # 调整响应创意的温度

chain = RetrievalQA.from_chain_type(llm=llm, chain_type="stuff", retriever=vectorstore.as_retriever())

# 4. 使用RAG模型

def get_answer(query):

return chain.run(query)

# 示例用法

query = "What are the key features of Company X's latest product?"

answer = get_answer(query)

print(answer)

#示例用法 公司历史

query = "When was Company X founded and who were the founders?"

answer = get_answer(query)

print(answer)

#示例用法 财务表现

query = "What were Company X's revenue and profit figures for the last quarter?"

answer = get_answer(query)

print(answer)

#示例用法 未来展望

query = "What are Company X's plans for expansion or new product development?"

answer = get_answer(query)

print(answer)

通过利用检索和生成的力量,RAG对改变我们与信息交互的方式和生成信息具有巨大的潜力,从而革新各种领域,并塑造人机交互的未来。

1.2 RAG如何解决复杂问题

检索增强生成(RAG)为传统大型语言模型(LLM)难以解决的复杂问题提供了强大的解决方案,特别是在涉及大量非结构化数据的情景中。

其中一个问题是在没有先前的微调或显式训练目标材料的情况下,能够就特定文档或多媒体内容(例如YouTube视频)进行有意义的对话。

传统的语言模型(LLM)尽管具有令人印象深刻的生成能力,但它们的参数化记忆在训练时是固定的。(Lewis et al., 2020)这意味着它们不能直接访问或整合超出训练数据的新信息,这使得它们难以就未见过的文档或视频进行有信息的讨论。

因此,当被询问与特定内容相关的查询时,LLM可能会生成不一致、不相关或事实不正确的响应。(Petroni et al., 2021)

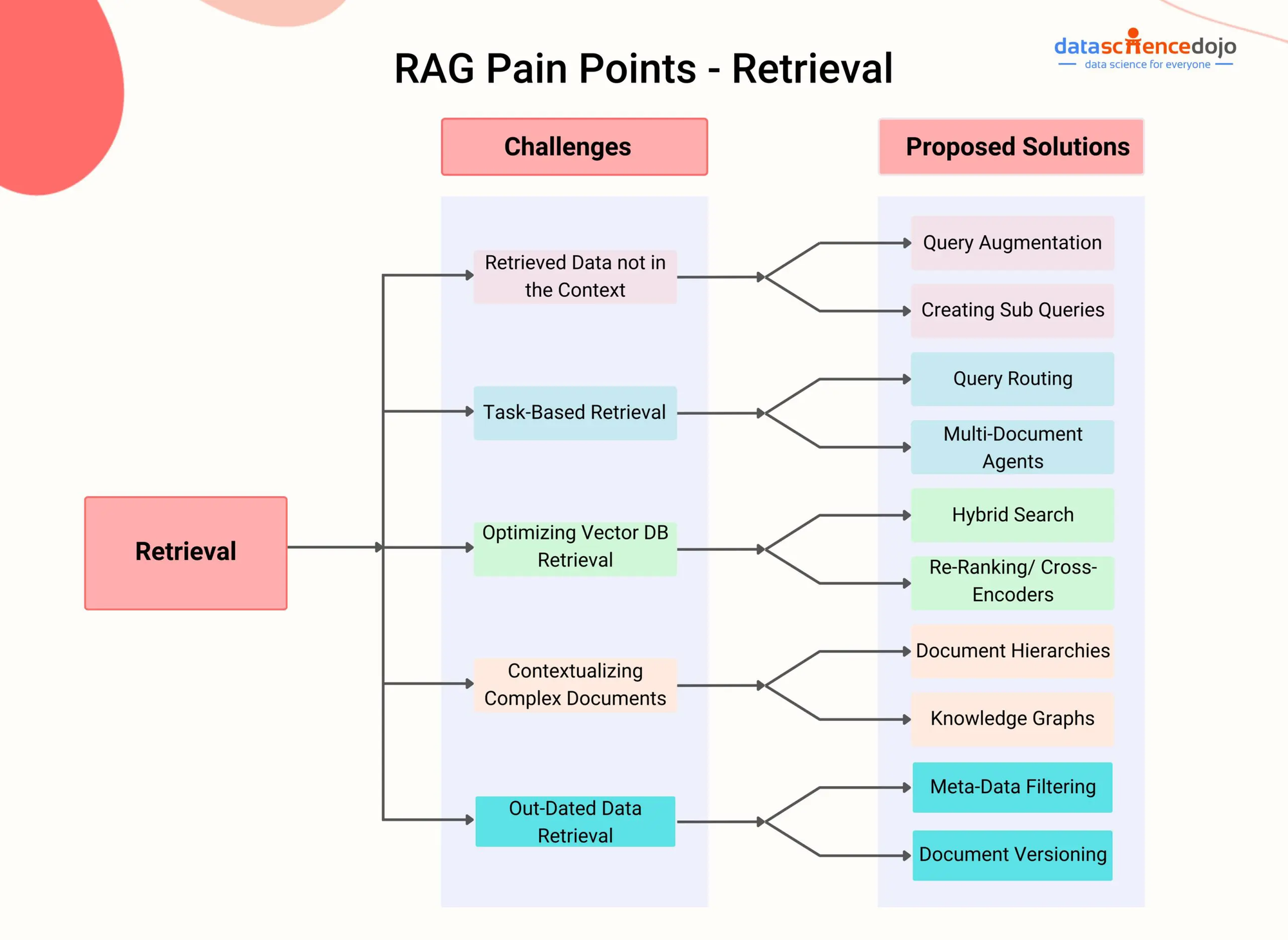

RAG痛点 – DataScienceDojo

RAG通过整合一个检索组件来解决这个问题,该组件使得模型能够在生成过程中动态地访问和整合来自外部知识源的相关信息。

通过利用先进的检索技术,如密集段落检索(Karpukhin et al., 2020)或混合搜索(Izacard & Grave, 2021),RAG系统可以根据对话上下文高效地识别出给定文档或视频中最为相关的段落或片段。

对于特定的YouTube科学话题视频,RAG系统可以首先转录视频的音频内容,然后使用密集向量表示对生成的文本进行索引。

然后,当用户提出与视频相关的问题时,RAG系统的检索组件可以根据查询与索引内容之间的语义相似性,快速识别转录中最为相关的段落。

检索到的段落随后被输入到生成模型中,该模型合成一个连贯且信息丰富的回应,直接回答用户的问题,并将答案建立在视频内容的基础上。Shuster等人,2021

这种方法使RAG系统能够就广泛的文档和多媒体内容进行知识丰富的对话,而无需明确的微调。通过动态检索和整合相关信息,RAG可以生成比传统LLM更准确、上下文相关和事实一致的回应。Lewis等人,2020

此外,RAG处理来自各种模态的非结构化数据的能力,如文本、图像和音频,使其成为处理涉及异质信息源的复杂问题的多功能解决方案。(Izacard & Grave, 2021)随着RAG系统的不断进化,它们解决跨越不同领域复杂问题的潜力也在增长。

通过利用先进的检索技术和多模态集成,RAG可以实现更智能、更上下文感知的人工智能对话代理、个性化的推荐系统以及知识密集型应用。

随着研究在高效索引、跨模态对齐和检索生成集成等领域的进展,RAG无疑将在推动语言模型和人工智能可能性边界方面发挥关键作用。

第二章:技术基础

本章深入探讨多模态检索增强生成(RAG)的迷人世界,这是一种超越传统基于文本模型局限性的前沿方法。

通过无缝集成图像、音频和视频等多种数据模态与大型语言模型(LLM),多模态RAG使人工智能系统能够在一个更丰富的信息景观上进行推理。

我们将探讨这种集成的背后机制,如对比学习和对跨模态注意力,以及它们如何使LLM生成更细致和上下文相关的响应。

虽然多模态RAG(如提高了准确性和支持视觉问题回答等新用例)带来了希望,但它也带来了独特挑战,包括对大规模多模态数据集的需求、计算复杂性的增加以及检索信息时可能存在的偏见。

在我们踏上这个旅程时,我们不仅将揭示多模态RAG的变革潜力,还将仔细研究前方的障碍,为这个快速发展的领域的深入理解铺平道路。

2.1 从神经语言模型到RAG

语言模型的演变是以从早期的基于规则系统向越来越复杂的基于统计和神经网络的模型稳步进展为标志的。

在早期,语言模型依赖于手工制定的规则和语言知识来生成文本,导致生成的是僵硬且有限的输出。统计模型的出现,如n元模型,引入了一种数据驱动的方法,从大量语料库中学习模式,使得生成更加自然和连贯的语言成为可能。(Redis)

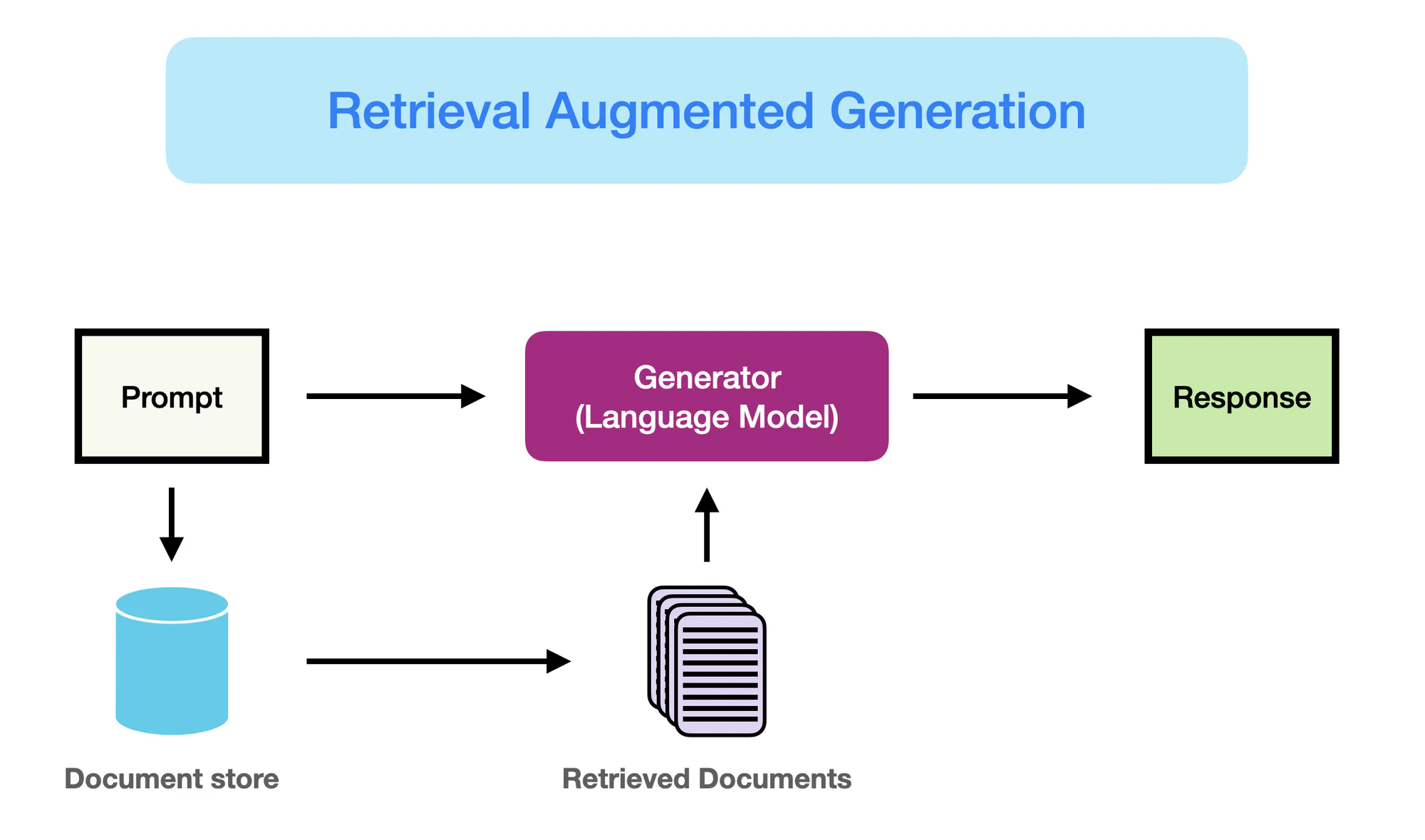

RAG工作原理 – promptingguide.ai

然而,是基于神经网络的模型,特别是像BERT和GPT-3这样的变压器架构,彻底改变了自然语言处理(NLP)领域。

这些模型,被称为大型语言模型(LLM),利用深度学习的力量捕捉复杂的语言模式,并以前所未有的流畅度和连贯性生成类似人类的文本。Yarnit随着LLM的复杂性和规模不断增加,像GPT-3这样拥有超过1750亿个参数的模型,在语言翻译、问题回答和内容创作等任务中表现出色。

尽管传统LLM的性能令人印象深刻,但它们由于依赖纯参数化记忆而存在局限性。StackOverflow这些模型中编码的知识是静态的,受到训练数据截止日期的限制。

因此,LLM可能会生成在事实上不正确或与最新信息不一致的输出。此外,缺乏对外部知识源的明确访问限制了它们在处理知识密集型查询时提供准确和上下文相关响应的能力。

检索增强生成(RAG)作为一种颠覆性的解决方案应运而生,以解决这些限制。通过将信息检索能力与LLM的生成能力无缝集成,RAG使得模型能够在生成过程中动态地访问和融入来自外部来源的相关知识。

这种参数化与非参数化记忆的结合使得配备RAG的LLM能够生成不仅流畅连贯,而且事实准确、情境相关的输出。

RAG在语言生成方面代表了重大飞跃,它将LLM的优势与外部知识库中丰富的知识相结合。通过利用这两种优势,RAG使模型能够生成更可靠、更具有信息量,并与现实世界知识相一致的文本。

这种范式转变开启了NLP应用的新可能性,从问答和内容创建到医疗保健、金融和科学研究等领域中的知识密集型任务。

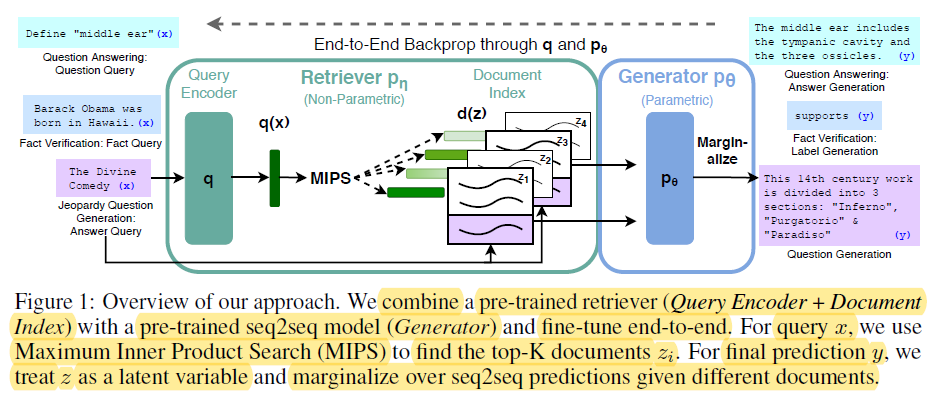

2.2 参数化与非参数化记忆

参数化记忆是指存储在如BERT和GPT-4等预训练语言模型参数中的知识。这些模型在训练过程中学习捕捉来自大量文本数据中的语言模式和关系,将这些知识编码在它们的数百万或数十亿个参数中。

通过q和p0的端到端反向传播 – miro.medium.com

通过q和p0的端到端反向传播 – miro.medium.com

参数化记忆的优势包括:

- 流畅性:预训练语言模型能够生成非常流畅且连贯的人造文本,捕捉到自然语言的细微差别和风格。(Redis 和 Lewis 等人。)

- 泛化能力:模型参数中编码的知识使得模型能够泛化到新的任务和领域,实现了迁移学习和少样本学习的能力。(Redis 和 Lewis 等人。)

然而,参数量化存储也存在明显的局限性:

- 事实错误:语言模型可能会生成与现实世界事实不一致的输出,因为它们的知识仅限于训练数据。

- 过时知识:模型参数中编码的知识随时间变得陈旧,因为它的知识在训练时固定,并不能反映现实世界的更新或变化。

- 高计算成本:训练大型语言模型需要大量的计算资源和能源,使得更新其知识变得昂贵且耗时。

- 常识: 语言模型所捕获的知识范围广泛且通用,缺乏许多领域特定应用所需的深度和具体性。

相比之下,非参数化记忆指的是使用显式知识源,如数据库、文档和知识图谱,为语言模型提供最新和准确的信息。这些外部来源作为记忆的补充形式,使模型能够在生成过程中按需访问和检索相关信息。

非参数化记忆的好处包括:

- 更新信息:外部知识源可以轻松更新和维护,确保模型能够访问最新和最准确的信息。

- 减少幻觉:”通过从外部源检索相关信息,RAG显著减少了幻觉或事实错误生成输出的发生率。”(Lewis 等人和Guu 等人)

- 领域特定知识:非参数记忆允许模型利用来自领域特定来源的专业知识,使特定应用的输出更加准确和上下文相关。(Lewis 等人。)和Guu 等人。)

参数记忆的限制突显了语言生成中范式转变的必要性。

RAG 通过整合信息检索技术,显著提高了生成模型的性能,代表了自然语言处理的重大进步。(Redis)

以下 Python 代码展示了在 RAG 背景下参数化和非参数化记忆的区别,并带有清晰的输出高亮显示:

from sentence_transformers import SentenceTransformer

from langchain.embeddings import HuggingFaceEmbeddings

from langchain.vectorstores import FAISS

from langchain.chains import RetrievalQAWithSourcesChain

from langchain.llms import OpenAI

# 示例文档集合(假设在实际场景中有更多详尽的文档)

documents = [

"The Large Hadron Collider (LHC) is the world's largest and most powerful particle accelerator.",

"The LHC is located at CERN, near Geneva, Switzerland.",

"The LHC is used to study the fundamental particles of matter.",

"In 2012, the LHC discovered the Higgs boson, a particle that gives mass to other particles.",

]

# 1. 非参数记忆(使用嵌入式检索)

model_name = "sentence-transformers/all-mpnet-base-v2"

embeddings = HuggingFaceEmbeddings(model_name=model_name)

vectorstore = FAISS.from_documents(documents, embeddings)

# 2. 参数记忆(带有检索的语言模型)

llm = OpenAI(temperature=0.1) # 调整响应创意的温度

chain = RetrievalQAWithSourcesChain.from_chain_type(llm=llm, chain_type="stuff", retriever=vectorstore.as_retriever())

# --- 查询与响应 ---

query = "What was discovered at the LHC in 2012?"

answer = chain.run(query)

print("Parametric (w/ Retrieval): ", answer["answer"])

query = "Where is the LHC located?"

docs = vectorstore.similarity_search(query)

print("Non-Parametric: ", docs[0].page_content)

输出:

Parametric (w/ Retrieval): The Higgs boson, a particle that gives mass to other particles, was discovered at the LHC in 2012.

Non-Parametric: The LHC is located at CERN, near Geneva, Switzerland.

此代码中所发生的事情如下:

参数化记忆:

- 利用大型语言模型(LLM)广泛的知识生成全面答案,包括希格斯玻色子赋予其他粒子质量的关键事实。LLM通过其广泛的训练数据进行“参数化”。

非参数化记忆:

- 在向量空间中进行相似性搜索,找到最相关的文档,直接回答有关大型强子对撞机(LHC)位置的问题。它不合成新信息,只是检索相关事实。

关键区别:

| Feature | Parametric Memory | Non-Parametric Memory |

|---|---|---|

| 知识存储 | 作为学习表示,编码在模型的参数(权重)中。 | 以原始文本或其他格式(例如,嵌入)直接存储。 |

| 检索 | 利用模型的生成能力产生与查询相关的文本,基于其学习到的知识。 | 涉及搜索与查询紧密匹配的文档(例如,通过相似性或关键词匹配)。 |

| 灵活性 | 高度灵活,可以生成新颖回应,但也可能产生幻觉(生成错误信息)。 | 较不灵活,但很少产生幻觉,因为它依赖于现有数据。 |

| 回应风格 | 可以产生更复杂和细致的回应,但也可能包含更多不相关信息。 | 提供直接且简洁的答案,但可能缺乏上下文或阐释。 |

| 计算成本 | 生成响应可能需要大量的计算资源,尤其是对于大型模型。 | 检索可能更快,特别是有了高效的索引和搜索算法。 |

通过结合参数化和非参数化记忆的优势,RAG解决了传统语言模型的局限性,并使生成更准确、更新、上下文相关的输出成为可能。(Redis,Lewis等人。,以及Guu等人。)

2.3 多模态RAG:集成文本

多模态RAG通过融合多种数据模态,如图像、音频和视频,扩展了基于文本的传统RAG范式,以增强大型语言模型(LLM)的检索和生成能力。

通过利用对比学习技术,多模态RAG系统学习将异质数据类型嵌入到一个共享的向量空间中,实现了无缝的跨模态检索。这使得LLM能够在更丰富的上下文中进行推理,结合文本信息与视觉和听觉线索,以生成更细致和上下文相关的输出。(Shen等人。)

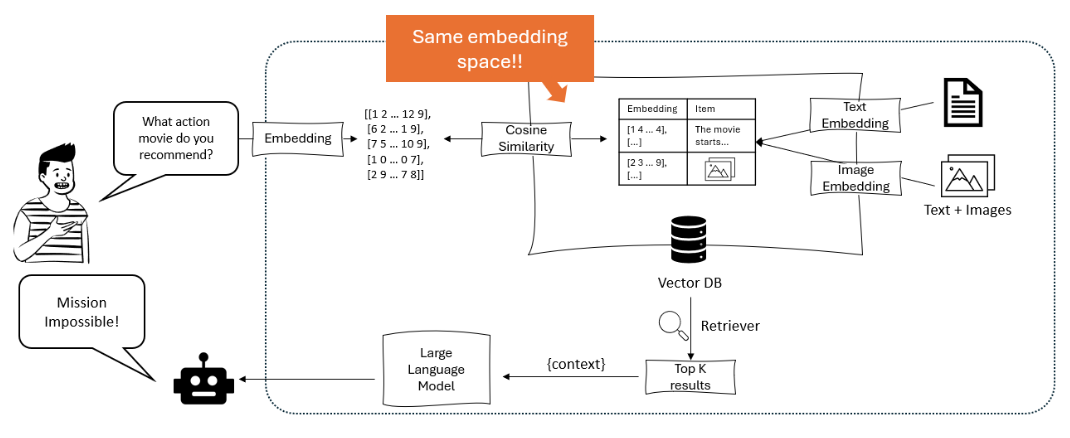

图示了一个推荐系统,在该系统中,大型语言模型将用户的查询转化为嵌入式表示,然后使用余弦相似度在包含文本和图像嵌入式的向量数据库中进行匹配,以检索并推荐最相关的项目。 – opendatascience.com

多模态RAG的一个关键方法是使用基于变压器的模型,如ViLBERT和LXMERT,这些模型采用跨模态注意力机制。这些模型在生成文本的同时,能够关注图像中的相关区域或音频/视频中的特定片段,捕捉模态之间细粒度的交互。这使得回应更加视觉化和情境化。(Protecto.ai)

RAG流水线中将文本与其他模态集成时,面临诸如在不同数据类型之间对齐语义表示和处理嵌入过程中每个模态的独特特性等挑战。为了应对这些挑战,使用了如模态特定编码和跨注意力等技术。(Zhu et al.)

但多模态RAG的潜在好处是巨大的,包括生成内容的准确性、可控性和可解释性的提高,以及支持诸如视觉问题回答和多模态内容创建等新型用例的能力。

例如,李等人(2020年)提出了一个多模态RAG框架,用于视觉问题回答,该框架检索相关的图像和文本信息以生成准确的答案,在VQA v2.0和CLEVR等基准测试中优于之前的最先进方法。(MyScale)

尽管结果很有希望,但多模态RAG也带来了新的挑战,如计算复杂性增加、需要大规模多模态数据集以及检索信息中可能存在的偏见和噪声。

研究人员正在积极探索缓解这些问题的技术,例如有效的索引结构、数据增强策略和对抗性训练方法。(Sohoni等人。)

第3章:RAG的核心机制

本章探讨了检索增强生成(RAG)系统中检索器与生成模型之间的复杂相互作用,突出了它们在索引、检索和合成信息以产生准确和上下文相关响应中的关键作用。

我们深入研究了稀疏和密集检索技术,比较了在不同场景下它们的优点和缺点。此外,我们还研究了将检索到的信息集成到生成模型中的各种策略,例如连接和交叉注意力,并讨论了它们对RAG系统整体有效性的影响。

通过理解这些集成策略,您将获得有关如何针对特定任务和领域优化RAG系统的宝贵见解,为更明智和有效的使用这一强大范式铺平道路。

3.1 RAG中信息检索和生成的力量

检索增强生成(RAG)代表了一种强大且无缝集成了信息检索和生成语言模型的范式。正如其名称所暗示的那样,RAG由两个主要组件组成:检索和生成。

检索组件负责索引和搜索庞大的知识库,而生成组件则利用检索到的信息产生上下文相关且事实准确的回应。(Redis 和 Lewis 等人)

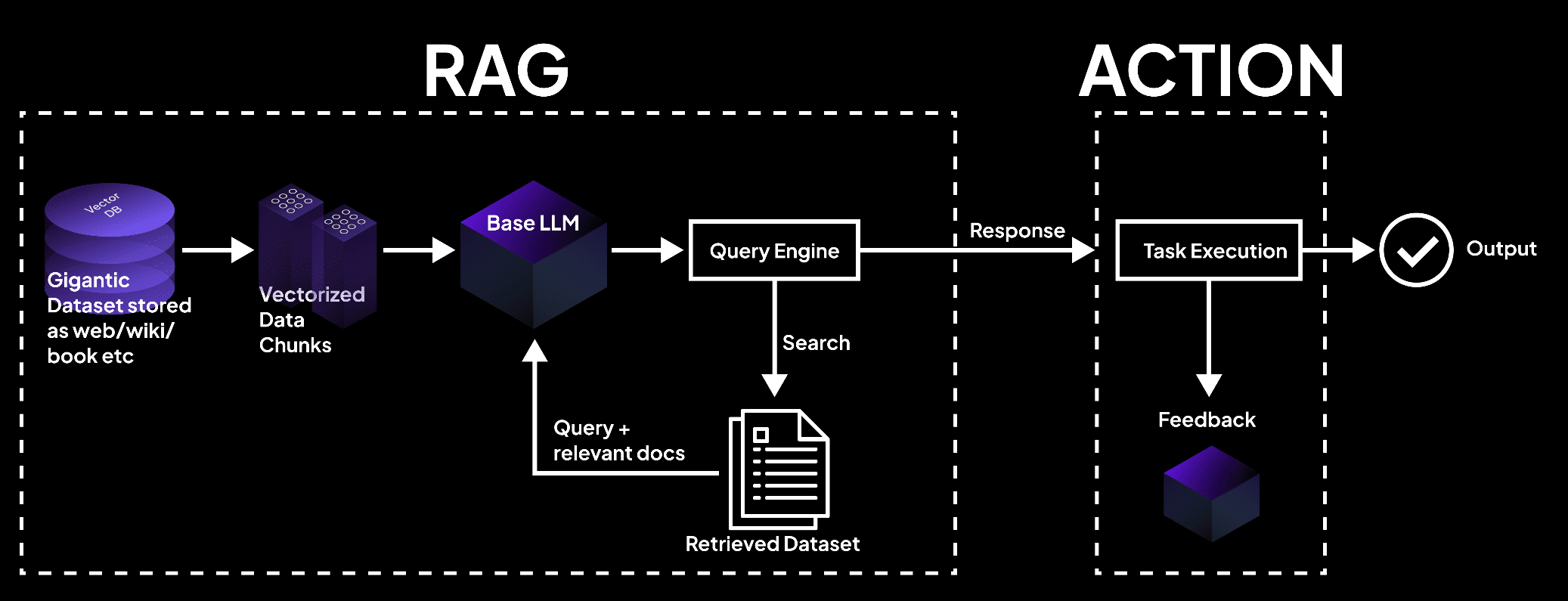

该图像展示了一个RAG系统,其中矢量数据库将数据处理成块,由语言模型查询以检索用于任务执行和精确输出的文档。 – superagi.com

检索过程从外部知识源的索引开始,如数据库、文档和网页。(Redis 和 Lewis 等人)检索器和索引器在这过程中的角色至关重要,它们有效地组织和存储信息,以便快速搜索和检索。

当向 RAG 系统提出查询时,检索器会搜索索引的知识库,根据语义相似性和其他相关度量指标识别最相关的信息。

一旦检索到相关信息,生成组件就会接管。检索到的内容用于提示和指导生成式语言模型,为其提供必要的上下文和事实依据,以生成准确且有用的响应。

语言模型采用先进的推理技术,如注意力机制和变压器架构,以合成检索到的信息与它的预先知识,生成连贯流畅的文本。

RAG 系统内信息的流动可以如下所示:

graph LR

A[Query] --> B[Retriever]

B --> C[Indexed Knowledge Base]

C --> D[Relevant Information]

D --> E[Generator]

E --> F[Response]

RAG 的优势是多方面的:

这种检索和生成能力的融合使得不仅能生成上下文适当的响应,还能利用最新的、准确的信息信息。(Guu等人)

通过利用外部知识源,RAG显著降低了虚构或事实不正确输出的发生率,这是纯粹生成模型常见的陷阱。

此外,RAG允许整合最新的信息,确保生成的响应反映给定领域最新的知识和进展。这在医疗保健、金融和科学研究等领域尤为重要,因为信息的准确性和及时性至关重要。(Guu等人和NVIDIA)

RAG还表现出卓越的适应性,使语言模型能够以提高性能处理各种任务。通过根据特定的查询或上下文动态检索相关信息,RAG使模型能够生成针对每个任务独特需求的响应,无论是回答问题、内容生成还是特定领域的应用。

大量研究已经证明了RAG在提高生成语言模型的事实准确性、相关性和适应性方面的有效性。

例如,Lewis等人(2020年)展示了RAG在一系列问答任务上优于纯粹的生成模型,在Natural Questions和TriviaQA等基准测试中取得了最先进的结果。(Lewis等人)

同样,Izacard和Grave(2021年)证明了RAG在生成连贯且事实一致的长篇文本方面优于传统语言模型。

检索增强生成代表了一种变革性的语言生成方法,利用信息检索的力量提高了生成模型的准确性、相关性和适应性。

通过将外部知识与预先存在的语言能力无缝集成,RAG为自然语言处理开辟了新的可能性,并为更智能、更可靠的语言生成系统铺平了道路。

3.2 检索器-生成器集成策略

检索增强生成(RAG)系统依赖于两个关键组件:检索器和生成模型。检索器负责从大规模知识库中高效地搜索和检索相关信息。

“它包括两个主要阶段,索引和搜索。索引组织文档以方便高效检索,使用稀疏检索的反向索引或密集检索的密集向量编码。”(Redis)

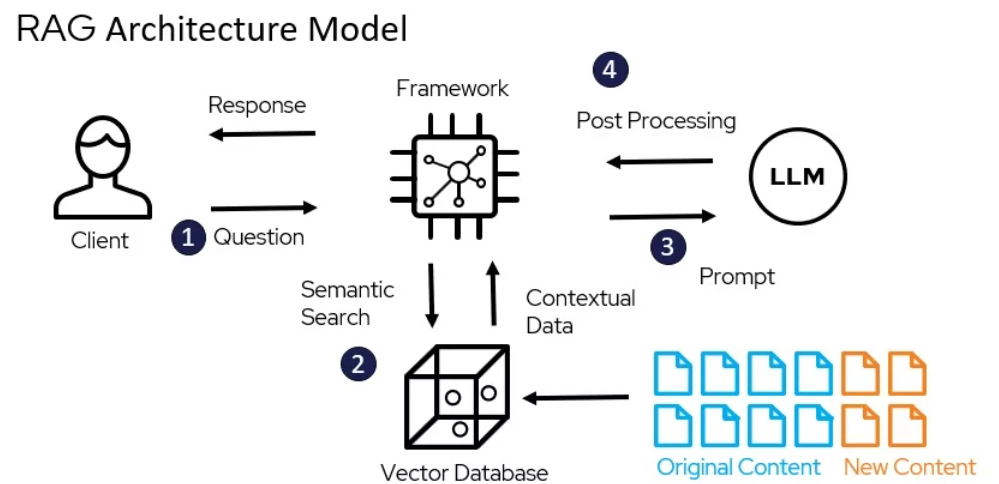

RAG的架构模型 – miro.medium.com

稀疏检索技术,如TF-IDF和BM25,将文档表示为高维稀疏向量,其中每个维度对应于词汇表中的一个唯一术语。文档与查询的相关性由术语的重叠确定,其权重由它们的重要性决定。

例如,使用流行的Elasticsearch库,可以如下实现基于TF-IDF的检索器:

from elasticsearch import Elasticsearch

es = Elasticsearch()

es.index(index="documents", doc_type="_doc", body={"text": "This is a sample document."})

query = "sample"

results = es.search(index="documents", body={"query": {"match": {"text": query}}})

密集检索技术,如密集段落检索(DPR)和基于BERT的模型,将文档和查询表示为连续嵌入空间中的密集向量。相关性由查询和文档向量之间的余弦相似度确定。

DPR可以使用Hugging Face Transformers库实现:

from transformers import DPRContextEncoder, DPRQuestionEncoder

context_encoder = DPRContextEncoder.from_pretrained("facebook/dpr-ctx_encoder-single-nq-base")

question_encoder = DPRQuestionEncoder.from_pretrained("facebook/dpr-question_encoder-single-nq-base")

context_embeddings = context_encoder(documents)

query_embedding = question_encoder(query)

scores = torch.matmul(query_embedding, context_embeddings.transpose(0, 1))

生成模型,如GPT和T5,用于在RAG中根据检索到的信息生成连贯且上下文相关的响应。在特定领域的数据上微调这些模型,并采用提示工程技术,可以显著提高它们在RAG系统中的性能。(DEV社区)

集成策略决定了检索内容如何被整合到生成模型中。

生成组件利用检索到的内容来形成连贯且上下文相关的响应,包括提示和推理阶段。(Redis)

有两种常见的方法:连接和跨注意力。

连接方法涉及将检索到的段落附加到输入查询,允许生成模型在解码过程中关注相关信息。

虽然实现简单,但这种方法可能难以处理长序列和不相关信息。(DEV 社区)跨注意力机制,如 RAG-Token 和 RAG-Sequence,允许生成模型在每个解码步骤中选择性地关注检索到的段落。

这使得整合过程更加精细,但计算复杂性也随之增加。

例如,RAG-Token 可以使用 Hugging Face Transformers 库实现:(

from transformers import RagTokenizer, RagRetriever, RagSequenceForGeneration

tokenizer = RagTokenizer.from_pretrained("facebook/rag-token-nq")

retriever = RagRetriever.from_pretrained("facebook/rag-token-nq", index_name="exact", use_dummy_dataset=True)

model = RagSequenceForGeneration.from_pretrained("facebook/rag-token-nq")

input_ids = tokenizer(query, return_tensors="pt").input_ids

retrieved_docs = retriever(input_ids)

generated_output = model.generate(input_ids, retrieved_docs=retrieved_docs)

选择检索器、生成模型和整合策略取决于 RAG 系统的具体要求,如知识库的大小和性质、希望效率和效果之间的平衡,以及目标应用领域。

第四章:应用和用例

本章探讨了检索增强生成(RAG)在革新低资源语言和多语言应用方面的转型潜力。我们深入研究了诸如将源文档翻译成资源丰富语言、利用多语言嵌入以及采用联邦学习等策略,以克服数据限制和语言差异。

此外,我们还解决了多语言RAG系统中减轻虚构现象的关键挑战,以确保生成内容的准确性和可靠性。通过探索这些创新方法,本章为利用RAG的力量为语言处理提供了一个全面的指南,以实现包容性和多样性。

4.1 RAG应用:从问答到创意写作

检索增强生成(RAG)在各个领域找到了众多实际应用,展示了其变革我们互动和生成信息潜力的能力。通过利用检索和生成的力量,RAG系统在准确性、相关性和用户参与度方面取得了显著改进。

RAG如何工作 – miro.medium.com

问答

RAG在问答领域已经被证明是一个游戏规则的改变者。通过从外部知识源检索相关信息并将其整合到生成过程中,RAG系统能够为用户查询提供更准确和上下文相关的响应。(LangChain和Django Stars)

例如,Izacard和Grave(2021)提出了一个基于RAG的模型,名为Fusion-in-Decoder(FiD),在多个问答基准测试中取得了最先进的表现,包括Natural Questions和TriviaQA。(Izacard and Grave)

FiD利用密集检索器获取相关段落和一个生成模型将检索到的信息合成连贯的答案,显著超过了纯粹的生成模型。(Izacard and Grave)

对话系统

RAG还在创建更吸引人、更有信息的对话代理方面找到了应用。通过检索方式融入外部知识,基于RAG的对话系统可以生成不仅在上下文上合适,而且基于事实的回应。 (自定义标签LlamaIndex和MyScale)

Shuster等人(2021年)引入了一个基于RAG的对话系统,名为BlenderBot 2.0,它展示了对前一代的改进对话能力。 (参考文献Shuster et al.)

BlenderBot 2.0从包括维基百科、新闻文章和社会媒体在内的多种知识来源中检索相关信息,使其能够就广泛主题进行更有见地和连贯的对话。 (Shuster et al.)

总结

RAG通过融入来自多个来源的相关信息,提高了生成摘要的质量。 (参考文献Hyperight)Pasunuru等人(2021年)提出了一种名为PEGASUS-X的基于RAG的摘要模型,它检索并整合来自外部文档的相关段落,以生成更有信息量和连贯性的摘要。

PEGASUS-X在多个摘要基准测试中超过了纯粹的生成模型,证明了检索在提高生成摘要的事实准确性和相关性方面的有效性。

创意写作

RAG的潜力不仅限于事实领域,还扩展到了创意写作领域。通过从多样化的文学作品中检索相关段落,RAG系统可以生成新颖引人入胜的故事或文章。

Rashkin等人(2020)介绍了一种基于RAG的创意写作模型CTRL-RAG,该模型从大规模小说数据集中检索相关段落并将它们整合到生成过程中。CTRL-RAG展示了能够生成连贯且风格一致的故事,证明了RAG在创意应用中的潜力。

案例研究

几篇研究论文和项目已经证明了RAG在各种领域的有效性。

例如,Lewis等人(2020)介绍了RAG框架并将其应用于开放领域的问题回答,在自然问题基准测试中取得了最先进的表现。(Lewis等人。)他们强调了高效检索的挑战和在整个段落上微调生成模型的的重要性。

在另一个案例研究中,Petroni等人(2021)将RAG应用于事实核查任务,展示了其检索相关证据和生成准确裁决的能力。他们展示了RAG在对抗虚假信息并提高信息系统的可靠性方面的潜力。

RAG对用户体验和业务指标的影响是显著的。通过提供更准确和有信息量的回应,基于RAG的系统改善了用户满意度和参与度。(LlamaIndex和MyScale)

在对话代理的案例中,RAG使得交互更加自然和连贯,从而提高了用户保留率和忠诚度。(LlamaIndex和MyScale)在创意写作领域,RAG有潜力简化内容创作过程并生成新颖想法,为企业节省时间和资源。

正如你所见,RAG的实际应用范围广泛,从问答和对话系统到摘录和创意写作。通过利用检索和生成的力量,RAG在准确性、相关性和用户参与度方面取得了显著改进。

随着该领域的不断发展,我们可以期待看到更多RAG的创新应用,转变我们在各种情境中与生成信息互动的方式。

4.2 针对低资源语言和多语言环境的RAG

利用检索增强生成(RAG)的力量服务于低资源语言和多语言环境,这不仅是一个机会,更是一种必需。全球有超过7000种语言,其中许多语言缺乏足够的数字资源,挑战显而易见:我们如何确保这些语言在数字时代不被落下?

翻译作为桥梁

一种有效的策略是在索引之前将源文档翻译成资源更丰富的语言。这种方法利用了像英语这样语言的广泛语料库,显著提高了检索的准确性和相关性。

通过将文档翻译成英语,您可以利用为高资源语言已开发的丰富资源和高级检索技术,从而提高低资源环境下RAG系统的性能。

多语言嵌入

多语言词汇嵌入的最新进展提供了另一个有前景的解决方案。通过为多种语言创建共享的嵌入空间,即使对于资源非常有限的语言,也可以提高跨语言的性能。

研究表明,结合具有高质量嵌入的中介语言可以弥合遥远语言对之间的差距,提高多语言嵌入的整体质量。

这种方法不仅提高了检索准确性,还确保了生成内容在上下文上的相关性和语言上的连贯性。

联邦学习

联邦学习提出了一种克服数据共享限制和语言差异的新方法。通过在分布式数据源上微调模型,您可以在保护用户隐私的同时,增强模型在多种语言上的性能。

与传统方法相比,这种方法已经展示了6.9%的更高准确性和99%的训练参数减少,使其成为多语言RAG系统的高效和有效解决方案。

减轻虚构现象

在多语言环境中部署RAG系统的关键挑战之一是减轻虚构现象——模型生成的事实上不正确或无关的信息的实例。

先进的RAG技术,如模块化RAG,引入了新的模块和微调策略来解决此问题。通过不断更新知识库并采用严格的评估指标,您可以显著减少虚构现象的发生,并确保生成的内容既准确又可靠。

实际实施

为了有效地实施这些策略,请考虑以下实际步骤:

- 利用翻译:在索引之前,将低资源语言文档翻译成高资源语言,如英语。

- 利用多语言嵌入:整合高质量嵌入的中间语言以提高跨语言性能。

- 采用联邦学习:在分布式数据源上微调模型,以增强性能的同时保护隐私。

- 减轻虚构现象:采用先进的RAG技术和持续的知识库更新,确保事实准确性。

通过采用这些策略,您可以在低资源和多语言环境中显著提高RAG系统的性能,确保不会在数字革命中落下任何语言。

第五章:优化技术

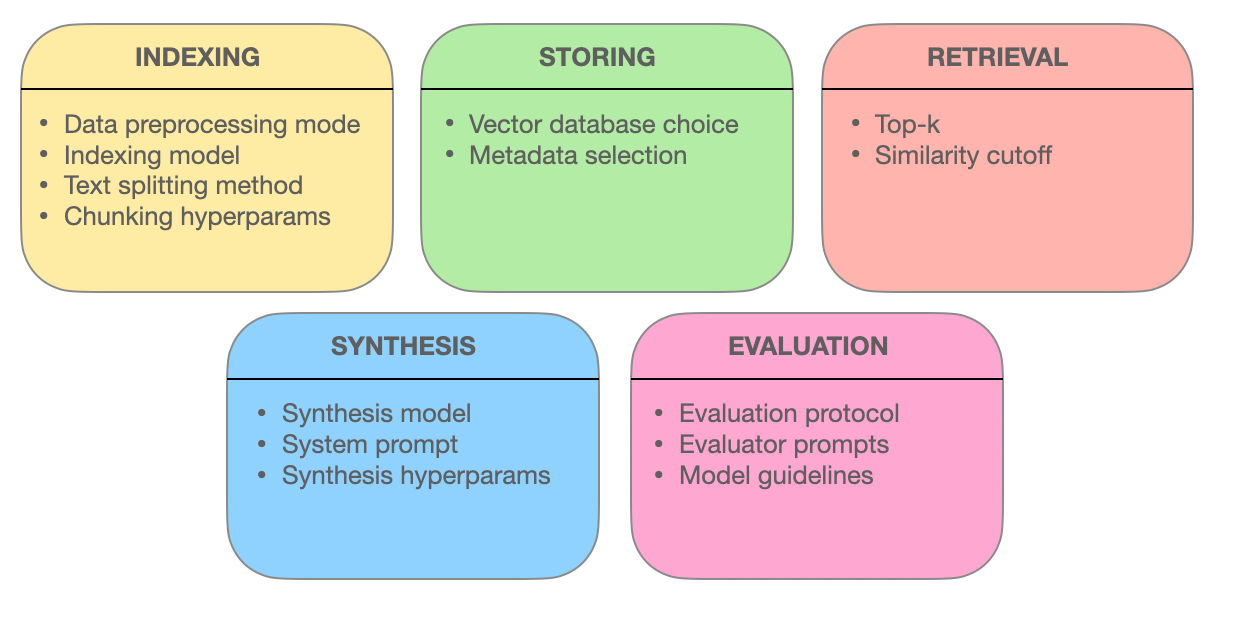

本章深入探讨了支撑检索增强生成(RAG)系统有效性的高级检索技术。我们研究了如何通过块优化、元数据集成、基于图的索引、对齐技术、混合搜索和重新排序来提高信息检索的准确性、相关性和全面性。

通过理解这些前沿方法,您将获得关于RAG系统如何从简单的搜索引擎演变成能够理解复杂查询并交付精确、上下文相关回应的智能信息提供者的洞见。

5.1 优化RAG系统的先进检索技术

检索增强生成(RAG)系统正在改变我们获取和利用信息的方式。这些系统的核心在于它们有效地检索相关信息的能力。

让我们更深入地探讨 empowering RAG 系统提供准确、上下文相关且全面的响应的高级检索技术。

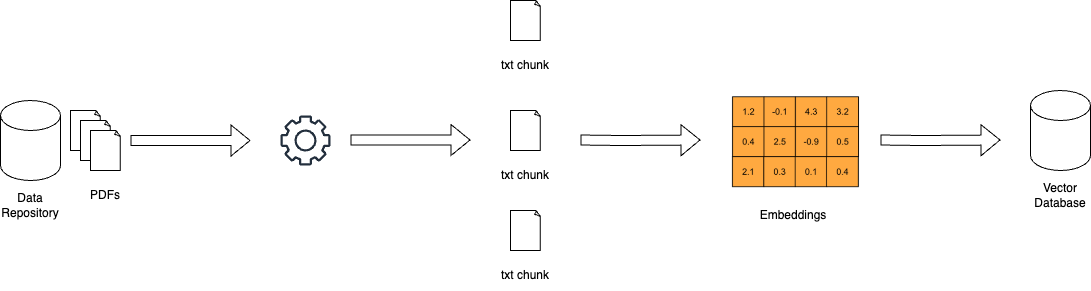

块优化:通过细粒度检索最大化相关性

在 RAG 系统中,大型文档可能令人望而却步。块优化通过将大量文本分解为更小、更易于管理的单元(称为块)来解决这一挑战。这种粒度使得检索系统能够精确地找到与查询词相匹配的特定文本部分,从而提高准确性和效率。

块优化的艺术在于确定理想的块大小和重叠程度。块太小可能缺乏上下文,而块太大可能稀释相关性。动态块分割是一种根据内容的结构和语义调整块大小的技术,确保每个块都是连贯且具有上下文意义的。

元数据集成:利用信息标签的力量

元数据是伴随文档的常被忽视的信息,对检索系统来说可能是一座金矿。通过集成如文档类型、作者、发布日期和主题标签等元数据,RAG 系统可以进行更精确的搜索。

由元数据集成支持的自我查询检索技术允许系统基于初始结果生成附加查询。这种迭代过程优化了搜索,确保检索的文档不仅符合查询,而且还能满足用户的特定需求和上下文需求。

高级索引结构:用于复杂查询的基于图的网络

传统的索引方法,如倒排索引和密集向量编码,在处理涉及多个实体及其关系的复杂查询时存在局限性。基于图的索引通过在图结构中组织文档及其连接提供了解决方案。

这种类图的组织允许在复杂场景中高效地遍历和检索相关文档。层次索引和近似最近邻搜索进一步增强了基于图的检索系统的可扩展性和速度。

对齐技术:确保准确性和减少幻觉

RAG系统的可信度取决于其提供准确信息的能力。对齐技术,如反事实训练,解决了这一问题。通过将模型暴露于假设场景,反事实训练教会模型区分现实世界的事实和生成的信息,从而减少幻觉。

在多模态RAG系统中,整合来自文本和图像等各种来源的信息,对比学习起着关键作用。这一技术对齐了不同数据模态的语义表示,确保检索的信息连贯且在语境上集成。

混合搜索:融合关键词精确性与语义理解

混合搜索结合了两者的优势:关键词搜索的速度和精确性与向量搜索的语义理解。最初,基于关键词的搜索快速缩小潜在文档的范围。

随后,基于向量的搜索根据语义相似性细化了结果。当需要精确的关键词匹配时,这种方法特别有效,但为了准确检索,还需要深入理解查询的意图。

重新排名:为最优响应细化相关性

在检索的最后阶段,重新排名阶段介入以微调结果。例如,跨编码器的机器学习模型重新评估检索到的文档的相关性得分。通过同时处理查询和文档,这些模型能够更深入地理解它们之间的关系。

这种精细的比较确保了排名靠前的文档确实与用户的查询和上下文保持一致,从而提供更加满意和有信息量的搜索体验。

RAG系统的强大之处在于它们能够无缝地检索和展示信息。通过采用这些先进的检索技术——块优化、元数据集成、基于图的索引、对齐技术、混合搜索和重新排名——RAG系统不仅仅是搜索引擎。它们演变成智能信息提供者,能够理解复杂查询、辨别细微差别,并交付精确、相关且可信赖的响应。

第6章:挑战与创新

本章深入探讨了Retrieval-Augmented Generation (RAG)系统开发和部署中的关键挑战和未来方向。

我们探讨了评估RAG系统的复杂性,包括全面指标和适应性框架的需求,以准确评估其性能。我们还解决了诸如偏见缓解和信息检索与生成中的公平性等伦理问题。

我们还研究了硬件加速和高效部署策略的重要性,强调了使用专用硬件和优化工具(如Optimum)以提高性能和可扩展性。

通过理解这些挑战并探索潜在解决方案,本章为RAG技术的持续发展和负责任实施提供了全面的路线图。

6.1 挑战与未来方向

检索增强生成(RAG)系统在提高生成文本的准确性、相关性和连贯性方面展示了巨大潜力。但是,RAG系统的发展和部署也带来了需要解决的重大挑战,以充分发挥其潜力。

“评估RAG系统因此涉及考虑许多具体组件以及整体系统评估的复杂性。”(Salemi等人)

评估RAG系统的挑战

RAG 技术挑战之一是确保从大规模知识库中高效检索相关信息。(Salemi 等人. 和 Yu 等人.)

随着知识来源的大小和多样性的持续增长,开发可扩展且健壮的检索机制变得越来越关键。需要探索分层索引、近似最近邻搜索和自适应检索策略等技术来优化检索过程。

RAG 系统中的某些元素 – miro.medium.com

另一个重大挑战是减轻虚构问题,即生成模型产生事实不正确或不一致的信息。

例如,一个 RAG 系统可能会生成一个从未发生过的历史事件或误将一项科学发现归功于他人。尽管检索有助于使生成的文本扎根于事实知识,但确保生成输出的忠实性和连贯性仍然是一个复杂的问题。

例如,一个 RAG 系统可以从像维基百科这样的可靠来源检索到关于某项科学发现的准确信息,但生成模型可能仍然会通过错误地结合这些信息或添加不存在的细节来虚构内容。

开发有效的机制来检测和预防幻觉是一个积极研究的领域。正在探索使用外部数据库进行事实验证和通过交叉引用多个来源进行一致性检查的技术。这些方法旨在确保生成的内容保持准确和可靠,尽管在检索和生成过程之间保持对齐存在固有的挑战。

在RAG系统中整合多样化的知识来源,如结构化数据库、非结构化文本和多模态数据,带来了额外的挑战。(Yu等人。和Zilliz)跨不同数据模态和知识格式对表示和语义进行对齐需要复杂的技术,如跨模态注意力和知识图嵌入。确保各种知识来源的兼容性和互操作性对于RAG系统的有效运行至关重要。(Zilliz)

除了技术挑战之外,RAG系统还引发了重要的伦理考量。确保无偏见和公平的信息检索和生成是一个关键的担忧。RAG系统可能会无意中放大训练数据或知识来源中存在的偏见,导致歧视性或具有误导性的输出。(Salemi等人和Banafa)

开发检测和缓解偏见的技术,如对抗性训练和公平性检索,是一个重要的研究方向。(Banafa)

未来研究方向

为了解决评估RAG系统的挑战,可以探索几个潜在的解决方案和研究方向。

开发全面的评估指标,捕捉检索准确性和生成质量之间的相互影响至关重要。(Salemi等人)

评估生成文本的相关性、连贯性和事实正确性时,需要考虑检索组件的有效性,并建立相应的度量标准。(Salemi等人)这需要一种全面的方法,超越传统的BLEU和ROUGE度量标准,并纳入人类评估和任务特定度量。

探索自适应和实时评估框架是另一个有前景的方向。

RAG系统在动态环境中运行,其中知识来源和用户需求可能会随时间演变。(于等人)开发能够适应这些变化并提供系统性能实时反馈的评估框架,对于持续改进和监控至关重要。

这可能涉及在线学习、主动学习和强化学习等技术,以根据用户反馈和系统行为更新评估指标和模型。(于等人)

研究人员、行业实践者和领域专家之间的合作努力是推进RAG评估领域所必需的。建立标准化的基准、数据集和评估协议可以促进不同领域和应用中RAG系统的比较和可重复性。 (Salemi等人。和Banafa)

与利益相关者,包括最终用户和政策制定者,的合作对于确保RAG系统的发展和部署与社会价值观和伦理原则保持一致至关重要。 (Banafa)

尽管RAG系统展示了巨大潜力,但解决它们评估中的挑战对于它们的广泛采用和信任至关重要。通过开发全面的评估指标、探索适应性和实时评估框架以及促进合作努力,我们可以为更可靠、无偏见和有效的RAG系统铺平道路。

随着领域的不断发展,优先考虑那些不仅推进RAG技术能力,也确保它们在现实世界应用中负责任和伦理部署的研究努力是至关重要的。

6.2 RAG系统的硬件加速和高效部署

利用硬件加速是Retrieval-Augmented Generation (RAG)系统高效部署的关键。通过将计算密集型任务卸载到专用硬件,您可以显著提高RAG模型的性能和可扩展性。

利用专用硬件

Optimum的硬件特定优化工具带来显著好处。例如,在Habana Gaudi处理器上部署RAG系统可以显著减少推理延迟,而Intel Neural Compressor优化可以进一步改善延迟指标。通过Optimum Neuron优化的AWS Inferentia硬件可以增强吞吐量能力,使您的RAG系统更加响应和高效。

优化资源利用

高效的资源利用至关重要。Optimum ONNX Runtime优化可以导致更有效的内存使用,而BetterTransformer API可以提高CPU和GPU的利用率。这些优化确保您的RAG系统以最佳效率运行,降低运营成本并提高性能。

可扩展性和灵活性

Optimum支持在不同硬件加速器之间无缝过渡,实现动态可扩展性。这种多硬件支持允许您适应不断变化的计算需求,而无需进行重大重构。此外,Optimum中的模型量化和小数特性可以实现更高效的模型大小,使部署更加容易且成本效益更高。

案例研究和现实世界应用

在健康信息检索中考虑Optimum的应用。通过利用硬件特定的优化,RAG系统能够高效地处理大型数据集,提供准确和及时的信息检索。这不仅提高了医疗服务质量,还增强了整体用户体验。

实施实用步骤

- 选择合适的硬件:根据您的特定性能要求,选择像Habana Gaudi或AWS Inferentia这样的硬件加速器。

- 使用优化工具:实施Optimum的优化工具,以提高延迟、吞吐量和资源利用率。

- 确保可扩展性:利用多硬件支持,根据需要动态扩展您的RAG系统。

- 优化模型大小:使用模型量化和小波削减,以降低计算开销并简化部署。

通过整合这些策略,您可以显著提高RAG系统的性能、可扩展性和效率,确保它们能够应对复杂、现实世界的应用。

结论:RAG的变革潜力

检索增强生成(RAG)代表了自然语言处理中的一个变革性范例,它无缝地将信息检索的力量与大型语言模型的生成能力相结合。

通过利用外部知识源,RAG系统在问答、对话系统、摘要和创意写作等各种应用中,展示了生成文本的准确性、相关性和连贯性的显著提高。

从早期的基于规则的系统发展到最先进的神经架构,如BERT和GPT-3,语言模型的演变铺平了RAG的出现之路。RAG通过检索机制融入非参数内存,有效解决了传统语言模型中纯粹参数化内存的限制,如知识截止日期和事实不一致的问题。

RAG系统的核心组件,即检索器和生成模型,协同工作以产生上下文相关且事实基础的输出。

检索器使用稀疏和密集检索等技术,有效地在庞大的知识库中搜索最相关的信息。生成模型利用GPT和T5等架构,将检索到的内容合成连贯流畅的文本。

集成策略,如连接和交叉注意力,决定了检索信息是如何融入生成过程的。

RAG的实用应用跨越多个领域,展示了其潜力,有望改变各个行业的面貌。

在问答任务中,RAG 显著提高了回答的准确性和相关性,使得信息检索更加信息丰富和可靠。对话系统从 RAG 中受益,使得对话更加生动和连贯。通过整合来自多个来源的相关信息,摘要任务的质量和平衡性得到了提高。甚至创造性写作也得到了探索,RAG 系统生成了新颖且风格一致的故事。

但 RAG 系统的发展和评估也带来了重大挑战。有效检索大规模知识库、减轻虚构现象以及整合多种数据模态等技术障碍需要解决。确保无偏见和公平的信息检索和生成对于负责任地部署 RAG 系统至关重要。

为了充分利用 RAG 的潜力,未来的研究重点必须集中在开发全面评估指标上,这些指标能够捕捉检索准确性和生成质量之间的相互影响。

适应性强和实时评估框架对于处理 RAG 系统的动态特性至关重要,以便持续改进和监控。研究人员、行业从业者和领域专家之间的协作努力对于建立标准化基准、数据集和评估协议是必要的。

随着检索和生成领域(RAG)的不断发展,它在改变我们与信息的交互方式和生成方式方面拥有巨大的潜力。通过利用检索和生成的力量,RAG系统有潜力彻底改变信息检索、对话代理、内容创建和知识发现等各个领域。

检索增强生成代表了通往更智能、更准确和上下文相关语言生成的道路上的一个重要里程碑。

通过连接参数化和非参数化记忆之间的鸿沟,RAG系统为自然语言处理及其应用开辟了新的可能性。

随着研究的进展和挑战的解决,我们可以预期RAG将在塑造未来人机交互和知识生成方面发挥越来越关键的作用。

关于作者

我是Vahe Aslanyan,位于计算机科学、数据科学和人工智能的交汇点。请访问vaheaslanyan.com查看一个见证了精确度和进步的作品集。我的经验横跨全栈开发和AI产品优化,致力于以新方法解决问题。

拥有推出领先的数据科学速成班和在业内与顶尖专家合作的经历,我的关注点始终在于将科技教育提升至普遍标准。

如何深入了解?

在学习完本指南后,如果您想要更深入地学习,并且喜欢结构化的学习方式,可以考虑加入LunarTech,我们提供数据科学、机器学习和人工智能的个人课程和速成班。

我们提供全面的课程,包括深入的理论理解、实际操作的实践实施、丰富的练习材料以及为您量身定制的面试准备,帮助您在各个阶段取得成功。

您可以查看我们的终极数据科学营,并加入免费试用,亲自体验内容。这已成为2023年最佳数据科学营之一,并在福布斯、雅虎、企业家等知名出版物上获得推荐。这是加入一个以创新和知识为生的社区的机会。欢迎信息如下

,请联系我。

月技术新闻通讯

如果您想了解更多关于数据科学、机器学习和人工智能领域的职业信息,以及如何获得数据科学职位,您可以免费下载这本数据科学和人工智能职业手册。

Source:

https://www.freecodecamp.org/news/retrieval-augmented-generation-rag-handbook/