LM 工作室 是一款用户友好的桌面应用程序,它允许您在您的 Linux 机器上本地下载、安装和运行大型语言模型(LLMs)。

使用 LM 工作室,您可以摆脱基于云的 AI 模型所带来的限制和隐私问题,同时仍能享受熟悉的 ChatGPT 式界面。

在本文中,我们将指导您使用 AppImage 格式在 Linux 上安装 LM 工作室,并提供一个在本地运行特定 LLM 模型的示例。

系统要求

在 Linux 上运行 LM 工作室 的最低硬件和软件要求如下:

- 至少具有 8GB VRAM 的专用 NVIDIA 或 AMD 显卡。

- 需要兼容 AVX2 的处理器和至少 16GB 的 RAM。

在 Linux 上安装 LM 工作室

开始之前,您需要从官方网站或仓库下载最新的 LM Studio AppImage。

下载 AppImage 后,您需要使其可执行并提取 AppImage 内容,这将自行解压到一个名为 squashfs-root 的目录中。

chmod u+x LM_Studio-*.AppImage ./LM_Studio-*.AppImage --appimage-extract

现在导航到提取的 squashfs-root 目录,并设置适当的权限给 chrome-sandbox 文件,这是一个应用程序需要安全运行的帮助程序二进制文件。

cd squashfs-root sudo chown root:root chrome-sandbox sudo chmod 4755 chrome-sandbox

现在您可以从提取的文件中直接运行LM Studio应用程序了。

./lm-studio

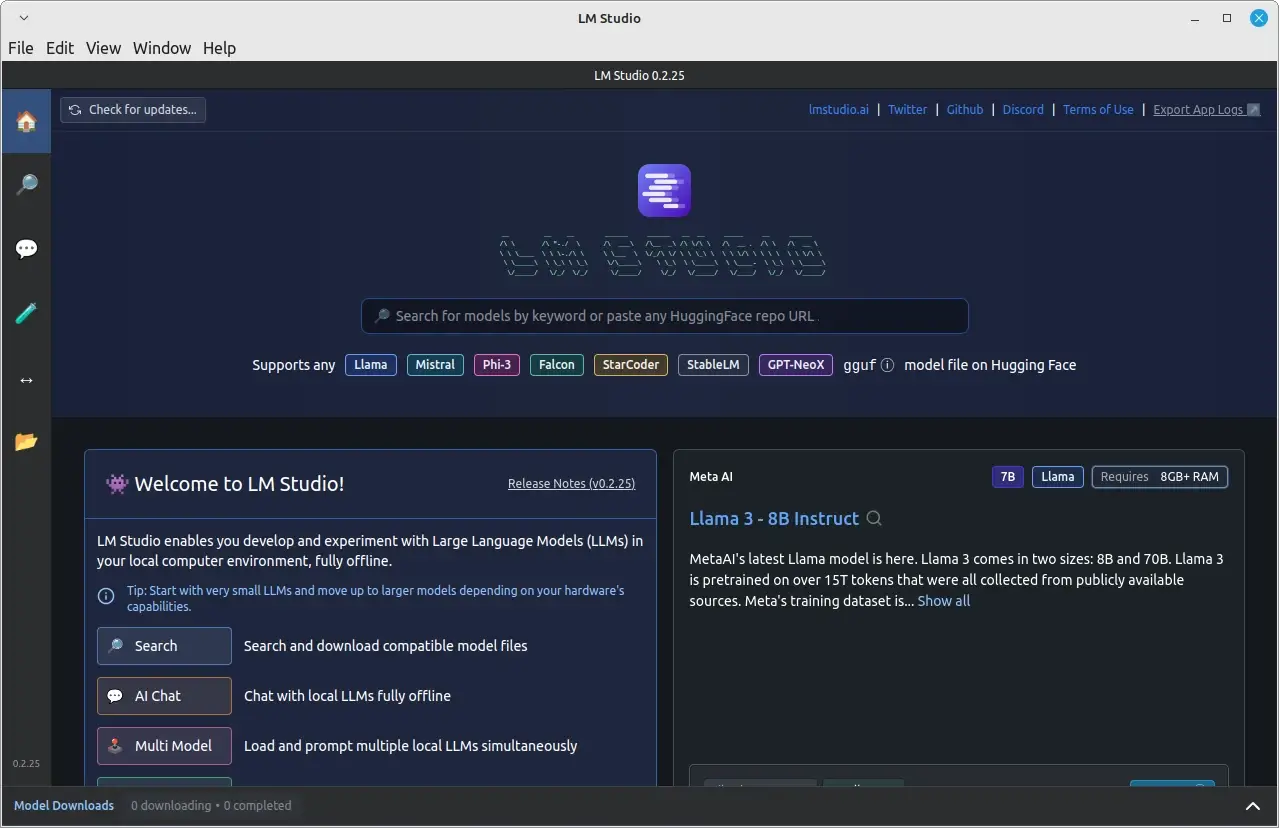

就是这样!LM Studio现在已安装在您的Linux系统上,您可以开始探索并在本地运行本地LLM。

在Linux上本地运行语言模型

成功安装并运行LM Studio后,您可以开始使用它来本地运行语言模型。

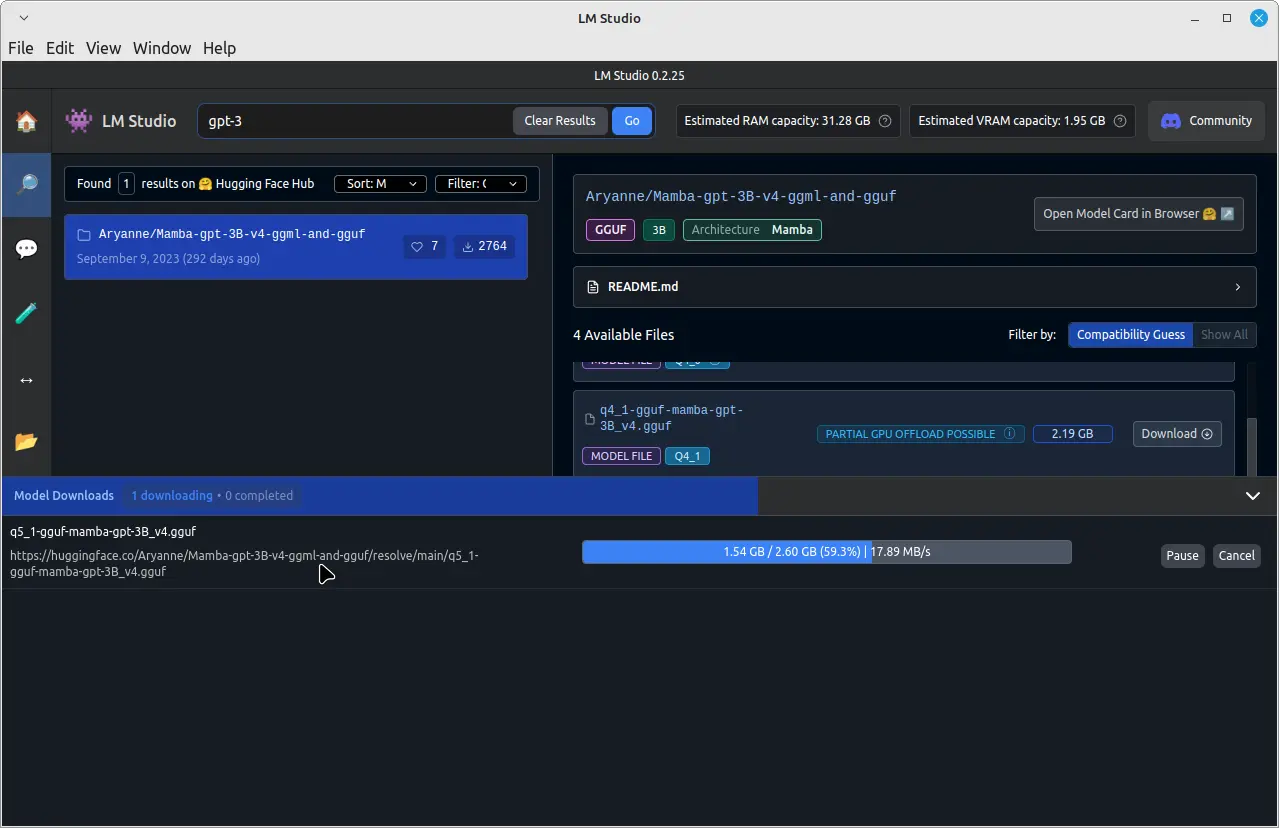

例如,要运行一个名为GPT-3的预训练语言模型,请点击顶部的搜索栏并输入“GPT-3”然后下载。

下载完成后,在左侧窗格中点击“聊天”选项卡。在“聊天”选项卡中,点击顶部下拉菜单并选择下载的GPT-3模型。

现在,您可以通过在聊天窗口底部的输入字段中键入消息来与GPT-3模型开始聊天。

GPT-3模型将处理您的消息并根据其培训提供回复。请注意,响应时间可能取决于您的系统硬件和下载的模型大小。

结论

通过使用LM Studio的AppImage格式在您的Linux系统上安装,您可以轻松地下载、安装并在不依赖基于云的服务的情况下本地运行大型语言模型。

这使您在享受先进 AI 模型优势的同时,能够更大程度地控制您的数据和隐私。请始终尊重知识产权,并遵守您下载和使用 LLMs 时 LM Studio 的使用条款。