LM Studio é uma aplicação de desktop amigável com o usuário que permite que você baixe, instale e execute modelos de linguagem de tamanho grande (LLMs) localmente em seu computador Linux.

Usando o LM Studio, você pode quebrar livre das limitações e preocupações de privacidade associadas a modelos de IA baseados em nuvem, enquanto ainda desfrutando de uma interface familiar como o ChatGPT.

Neste artigo, nós vamos guiar você pelo processo de instalação do LM Studio no Linux usando o formato AppImage e fornecer um exemplo de execução de um modelo de LLM específico localmente.

Requisitos de Sistema

As exigências mínimas de hardware e software para executar o LM Studio no Linux são:

- Cartão de gráficos NVIDIA ou AMD dedicado com pelo menos 8GB de VRAM.

- É necessário um processador compatible com AVX2 e pelo menos 16GB de RAM.

Instalando o LM Studio no Linux

Para começar, você precisa baixar a versão mais recente do LM Studio AppImage do site oficial ou do repositório.

Uma vez o AppImage baixado, você precisa torná-lo executável e extrair o conteúdo do AppImage, o que irá descompactar automaticamente para uma pasta chamada squashfs-root.

chmod u+x LM_Studio-*.AppImage ./LM_Studio-*.AppImage --appimage-extract

Agora, navegue até a pasta extraída squashfs-root e defina as permissões apropriadas para o arquivo chrome-sandbox, que é um arquivo de auxílio binário que a aplicação precisa para executar de forma segura.

cd squashfs-root sudo chown root:root chrome-sandbox sudo chmod 4755 chrome-sandbox

Agora você pode executar a aplicação LM Studio diretamente dos arquivos extraídos.

./lm-studio

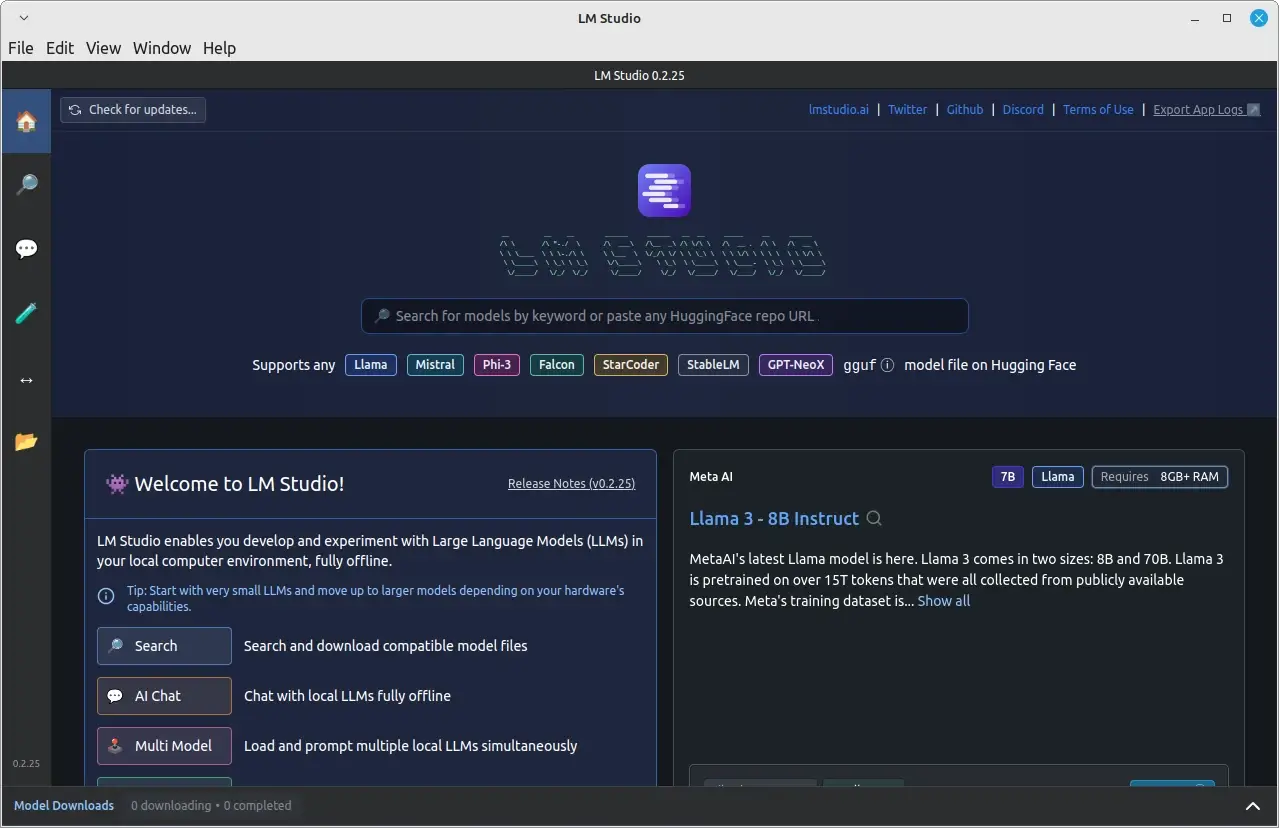

Pronto! LM Studio agora está instalado no seu sistema Linux e você pode começar a explorar e executar modelos de LLM locais.

Executar um Modelo de Linguagem Localmente no Linux

Após instalar e executar LM Studio com sucesso, você pode começar a usá-lo para executar modelos de linguagem localmente.

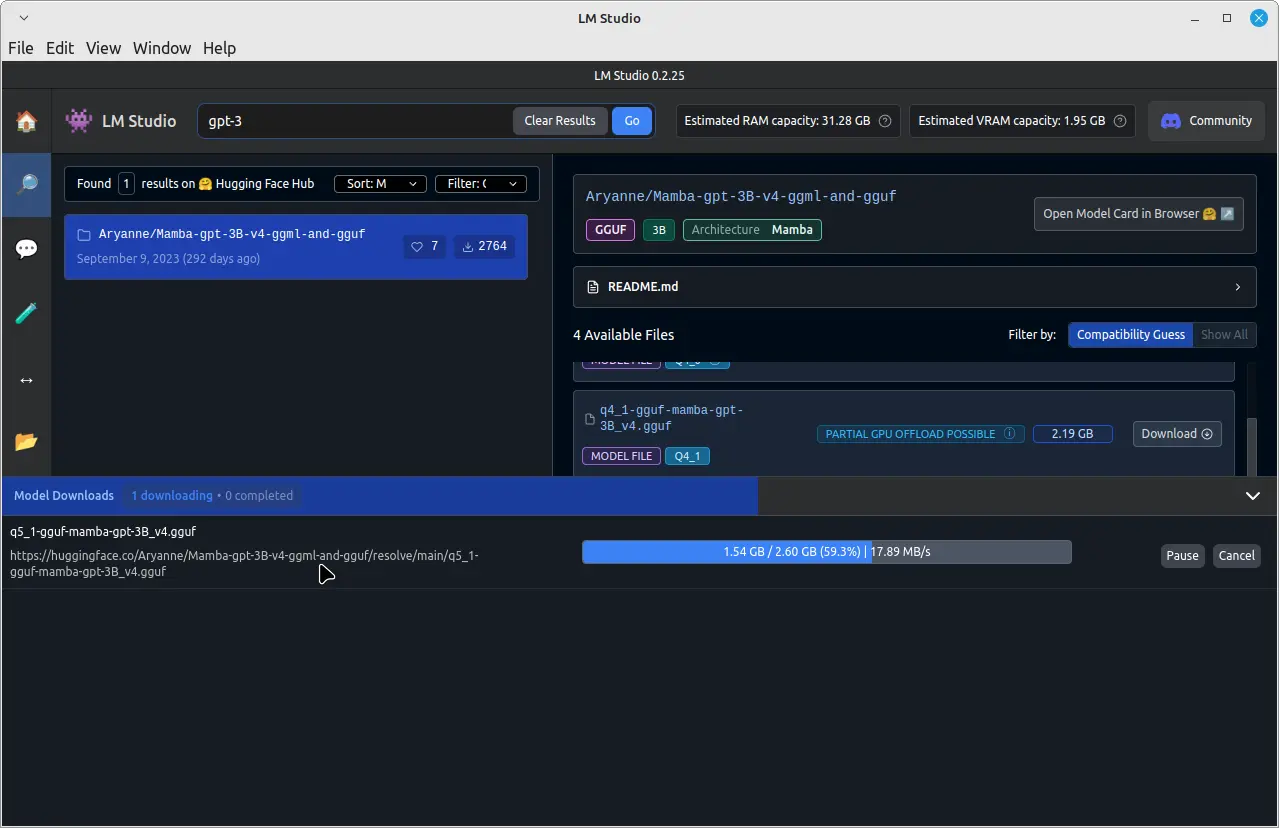

Por exemplo, para executar um modelo de linguagem pré-treinado chamado GPT-3, clique na barra de busca no topo e digite “GPT-3” e faça o download.

Uma vez que o download for concluído, clique na aba “Chat” no painel esquerdo. Na aba “Chat”, clique no menu suspenso no topo e selecione o modelo GPT-3 baixado.

Agora você pode começar a conversar com o modelo GPT-3 digitando suas mensagens no campo de entrada no final da janela de bate-papo.

O modelo GPT-3 processará suas mensagens e fornecerá respostas com base em seu treinamento. Note que o tempo de resposta pode variar dependendo do hardware do seu sistema e do tamanho do modelo baixado.

Conclusão

Instalando LM Studio em seu sistema Linux usando o formato AppImage, você pode facilmente baixar, instalar e executar grandes modelos de linguagem localmente sem depender de serviços baseados em nuvem.

Isto dá a você maior controle sobre seus dados e privacidade, enquanto ainda desfruta dos benefícios de modelos avançados de IA. Lembre-se de sempre respeitar os direitos de propriedade intelectual e adherir aos termos de uso para os LLMs que você baixa e executa usando o LM Studio.