Em uma era caracterizada por um aumento exponencial na geração de dados, as organizações devem aproveitar efetivamente essa riqueza de informações para manter sua vantagem competitiva. A busca e análise eficientes de dados de clientes — como identificar preferências de usuários para recomendações de filmes ou análise de sentimentos — desempenham um papel crucial na tomada de decisões informadas e na melhoria das experiências dos usuários. Por exemplo, um serviço de streaming pode empregar busca vetorial para recomendar filmes adaptados aos históricos de visualização e avaliações individuais, enquanto uma marca de varejo pode analisar os sentimentos dos clientes para aprimorar as estratégias de marketing.

Como engenheiros de dados, somos responsáveis por implementar essas soluções sofisticadas, garantindo que as organizações possam extrair insights acionáveis de vastos conjuntos de dados. Este artigo explora as complexidades da busca vetorial usando Elasticsearch, focando em técnicas eficazes e melhores práticas para otimizar o desempenho. Ao examinar estudos de caso sobre recuperação de imagens para marketing personalizado e análise de texto para agrupamento de sentimentos de clientes, demonstramos como a otimização da busca vetorial pode levar a interações melhoradas com os clientes e um crescimento significativo nos negócios.

O que é Busca Vetorial?

A busca vetorial é um método poderoso para identificar semelhanças entre pontos de dados, representando-os como vetores em um espaço de alta dimensão. Essa abordagem é particularmente útil para aplicações que requerem recuperação rápida de itens similares com base em seus atributos.

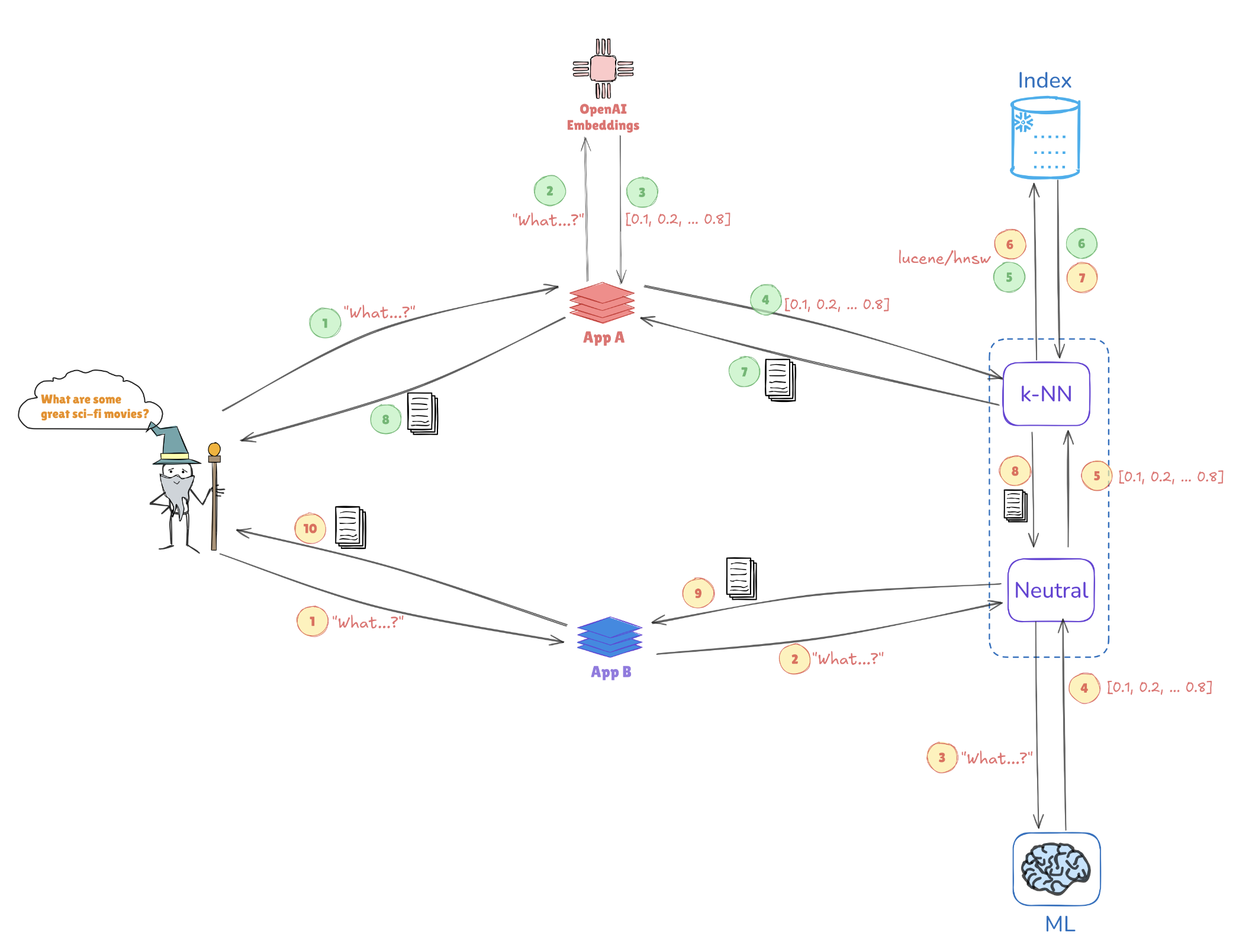

Ilustração da Busca Vetorial

Considere a ilustração abaixo, que mostra como as representações vetoriais possibilitam buscas por semelhança:

- Embutiduras de consulta: A consulta “Quais são alguns ótimos filmes de ficção científica?” é convertida em uma representação vetorial, como [0.1, 0.2, …, 0.4].

- Indexação: Este vetor é comparado com vetores pré-indexados armazenados no Elasticsearch (por exemplo, de aplicações como AppA e AppB) para encontrar consultas ou pontos de dados similares.

- Busca k-NN: Usando algoritmos como k-Nearest Neighbors (k-NN), o Elasticsearch recupera de forma eficiente as melhores correspondências dos vetores indexados, ajudando a identificar as informações mais relevantes rapidamente.

Esse mecanismo permite que o Elasticsearch se destaque em casos de uso como sistemas de recomendação, buscas de imagens e processamento de linguagem natural, onde compreender o contexto e a semelhança é fundamental.

Principais Benefícios da Busca Vetorial com Elasticsearch

Suporte à Alta Dimensionalidade

O Elasticsearch se destaca na gestão de estruturas de dados complexas, essenciais para aplicações de IA e aprendizado de máquina. Essa capacidade é crucial ao lidar com tipos de dados multifacetados, como imagens ou dados textuais.

Escalabilidade

A arquitetura do Elasticsearch suporta escalabilidade horizontal, permitindo que as organizações lidem com conjuntos de dados em constante expansão sem sacrificar o desempenho. Isso é vital à medida que os volumes de dados continuam a crescer.

Integração

O Elasticsearch funciona de maneira integrada com o Elastic stack, fornecendo uma solução abrangente para ingestão, análise e visualização de dados. Essa integração garante que os engenheiros de dados possam aproveitar uma plataforma unificada para diversas tarefas de processamento de dados.

Melhores Práticas para Otimizar o Desempenho de Busca Vetorial

1. Reduzir Dimensões Vetoriais

A redução da dimensionalidade de seus vetores pode melhorar significativamente o desempenho da busca. Técnicas como PCA (Análise de Componentes Principais) ou UMAP (Aproximação e Projeção de Variedades Uniformes) ajudam a manter características essenciais enquanto simplificam a estrutura dos dados.

Exemplo: Redução de Dimensionalidade com PCA

Veja como implementar PCA em Python usando Scikit-learn:

from sklearn.decomposition import PCA

import numpy as np

# Sample high-dimensional data

data = np.random.rand(1000, 50) # 1000 samples, 50 features

# Apply PCA to reduce to 10 dimensions

pca = PCA(n_components=10)

reduced_data = pca.fit_transform(data)

print(reduced_data.shape) # Output: (1000, 10)

2. Indexar de Forma Eficiente

Aproveitar algoritmos de Vizinhos Mais Próximos Aproximados (ANN) pode acelerar significativamente os tempos de busca. Considere usar:

- HNSW (Hierarchical Navigable Small World): Conhecido por seu equilíbrio entre desempenho e precisão.

- FAISS (Facebook AI Similarity Search): Otimizado para grandes conjuntos de dados e capaz de utilizar aceleração por GPU.

Exemplo: Implementando HNSW no Elasticsearch

Você pode definir suas configurações de índice no Elasticsearch para utilizar HNSW da seguinte forma:

PUT /my_vector_index

{

"settings": {

"index": {

"knn": true,

"knn.space_type": "l2",

"knn.algo": "hnsw"

}

},

"mappings": {

"properties": {

"my_vector": {

"type": "knn_vector",

"dimension": 10 // Adjust based on your data

}

}

}

}

3. Consultas em Lote

Para aumentar a eficiência, o processamento em lote de várias consultas em uma única solicitação minimiza a sobrecarga. Isso é particularmente útil para aplicações com alto tráfego de usuários.

Exemplo: Processamento em Lote no Elasticsearch

Você pode usar o endpoint _msearch para consultas em lote:

POST /_msearch

{ "index": "my_vector_index" }

{ "query": { "match_all": {} } }

{ "index": "my_vector_index" }

{ "query": { "match": { "category": "sci-fi" } } }

4. Use Cache

Implemente estratégias de cache para consultas frequentemente acessadas para diminuir a carga computacional e melhorar os tempos de resposta.

5. Monitore o Desempenho

Analisar regularmente as métricas de desempenho é crucial para identificar gargalos. Ferramentas como Kibana podem ajudar a visualizar esses dados, permitindo ajustes informados na sua configuração do Elasticsearch.

Ajustando Parâmetros no HNSW para Melhorar o Desempenho

Otimizar o HNSW envolve ajustar certos parâmetros para alcançar um melhor desempenho em grandes conjuntos de dados:

M(número máximo de conexões): Aumentar este valor melhora a recuperação, mas pode exigir mais memória.EfConstruction(tamanho da lista dinâmica durante a construção): Um valor mais alto resulta em um gráfico mais preciso, mas pode aumentar o tempo de indexação.EfSearch(tamanho da lista dinâmica durante a busca): Ajustar isso afeta a troca de velocidade-precisão; um valor maior proporciona uma melhor lembrança, mas leva mais tempo para calcular.

Exemplo: Ajustando Parâmetros HNSW

Você pode ajustar os parâmetros HNSW em sua criação de índice assim:

PUT /my_vector_index

{

"settings": {

"index": {

"knn": true,

"knn.algo": "hnsw",

"knn.hnsw.m": 16, // More connections

"knn.hnsw.ef_construction": 200, // Higher accuracy

"knn.hnsw.ef_search": 100 // Adjust for search accuracy

}

},

"mappings": {

"properties": {

"my_vector": {

"type": "knn_vector",

"dimension": 10

}

}

}

}

Estudo de Caso: Impacto da Redução da Dimensionalidade no Desempenho do HNSW em Aplicações de Dados do Cliente

Recuperação de Imagem para Marketing Personalizado

Técnicas de redução da dimensionalidade desempenham um papel fundamental na otimização de sistemas de recuperação de imagem em aplicações de dados do cliente. Em um estudo, pesquisadores aplicaram Análise de Componentes Principais (PCA) para reduzir a dimensionalidade antes de indexar imagens com redes Hierárquicas Navegáveis Pequeno Mundo (HNSW). O PCA proporcionou um impulso notável na velocidade de recuperação — vital para aplicações que lidam com grandes volumes de dados do cliente — embora isso tenha vindo com o custo de uma pequena perda de precisão devido à redução de informação. Para lidar com isso, os pesquisadores também examinaram a Aproximação e Projeção Uniforme de Manifolds (UMAP) como uma alternativa. UMAP preservou estruturas de dados locais de forma mais eficaz, mantendo os detalhes intricados necessários para recomendações de marketing personalizadas. Embora o UMAP exigisse maior poder computacional do que o PCA, ele equilibrou a velocidade de busca com alta precisão, tornando-o uma escolha viável para tarefas críticas de precisão.

Análise de Texto para Agrupamento de Sentimentos do Cliente

No campo da análise de sentimentos dos clientes, um estudo diferente descobriu que o UMAP supera o PCA na agrupamento de dados textuais semelhantes. O UMAP permitiu que o modelo HNSW agrupasse os sentimentos dos clientes com maior precisão — uma vantagem na compreensão do feedback dos clientes e na entrega de respostas mais personalizadas. O uso do UMAP facilitou valores menores de EfSearch no HNSW, melhorando a velocidade e a precisão da busca. Essa eficiência de agrupamento aprimorada possibilitou uma identificação mais rápida de sentimentos relevantes dos clientes, melhorando os esforços de marketing direcionado e a segmentação de clientes baseada em sentimentos.

Integração de Técnicas de Otimização Automatizada

Otimizar a redução de dimensionalidade e os parâmetros do HNSW é essencial para maximizar o desempenho dos sistemas de dados dos clientes. Técnicas de otimização automatizada agilizam esse processo de ajuste, garantindo que as configurações selecionadas sejam eficazes em diversas aplicações:

- Busca em grade e aleatória: Esses métodos oferecem uma exploração ampla e sistemática dos parâmetros, identificando configurações adequadas de forma eficiente.

- Otimização bayesiana: Essa técnica se concentra em parâmetros ótimos com menos avaliações, economizando recursos computacionais.

- Validação cruzada: A validação cruzada ajuda a validar parâmetros em diversos conjuntos de dados, garantindo sua generalização para diferentes contextos de dados de clientes.

Abordando Desafios na Automação

Integrar automação dentro dos fluxos de trabalho de redução de dimensionalidade e HNSW pode introduzir desafios, particularmente na gestão das demandas computacionais e na evitação de overfitting. As estratégias para superar esses desafios incluem:

- Redução da sobrecarga computacional: O uso de processamento paralelo para distribuir a carga de trabalho reduz o tempo de otimização, aumentando a eficiência dos fluxos de trabalho.

- Integração modular: Uma abordagem modular facilita a integração perfeita de sistemas automatizados em fluxos de trabalho existentes, reduzindo a complexidade.

- Prevenção do overfitting: Validação robusta através de validação cruzada garante que os parâmetros otimizados tenham desempenho consistente em diferentes conjuntos de dados, minimizando o overfitting e aumentando a escalabilidade em aplicações de dados de clientes.

Conclusão

Ao aproveitar totalmente o desempenho da busca vetorial no Elasticsearch, adotar uma estratégia que combine redução de dimensionalidade, indexação eficiente e ajuste cuidadoso de parâmetros é essencial. Ao integrar essas técnicas, engenheiros de dados podem criar um sistema de recuperação de dados altamente responsivo e preciso. Métodos de otimização automatizados elevam ainda mais esse processo, permitindo um refinamento contínuo dos parâmetros de busca e das estratégias de indexação. À medida que as organizações dependem cada vez mais de insights em tempo real a partir de vastos conjuntos de dados, essas otimizações podem melhorar significativamente as capacidades de tomada de decisão, oferecendo resultados de busca mais rápidos e relevantes. Abraçar essa abordagem prepara o terreno para futura escalabilidade e melhor responsividade, alinhando as capacidades de busca com as demandas empresariais em evolução e o crescimento dos dados.

Source:

https://dzone.com/articles/optimizing-vector-search-performance-with-elasticsearch