소개

Apache Kafka는 클러스터에 허가된 인물과 应用程序만이 연결할 수 있게 보호하기 위해 다양한 보안 프로tokolle 및 인증 workflow를 지원합니다. 기본 구성에서 Kafka는 모두에게 アクセス 허가를 한지만, 보안 검사를 사용하지 않습니다. 이것은 탐색과 開発에 유용하지만, 생산적인 배포는 外的에 노출되기 전에 적절히 보안되어야 합니다. 또한, 이러한 환경은 시계열 운영과 불가义한 문제를 예방る 수행을 모니터링해야 합니다.

이 튜토리얼에서는 TLS 트래픽 암호화와 SASL 인증을 구성하여 표준적인 사용자 이름과 암호 로그인 과정을 제공하는 방법을 배울 것입니다. 제공된 생산자와 수신자 스크립트를 구성하여 보호된 クラス터에 연결할 수 있는 方法을 보여줍니다. 그리고 Kafka 지표를 eksポrt하고 Grafana에서 이를 시각화하는 方法을 배울 것입니다. 또한 AKHQ로부터 제공되는 사용하기 간편한 웹 기반 인터페이스를 사용하여 클러스터의 노드와 주제에 접근하는 方法을 배울 것입니다.

예제 준비

이 튜토리얼을 완료하기 위해서는 다음과 같은 것을 필요로 합니다:

- 최소 4GB RAM과 2개 CPU를 갖춘 드롭เล็ต. Ubuntu 서버의 경우 설정 지침을 위해 초기 서버 설정를 따라야 합니다.

- 드롭เล็ต에 Apache Kafka가 설치되고 설정되었습니다. 설정 지침을 위해 Kafka 소개 튜토리얼을 따라야 합니다. 스텝 1과 스텝 2만 완료하면 됩니다.

- Java가 키와 인증서를 어떻게 처리하는지 이해해야 합니다. 더 많은 정보는 Java Keytool Essetials: Java Keystore로 작업하기 튜토리얼에 방문하세요.

- 서버나 로컬 머신에 설치된 Grafana. 지침을 위해 Ubuntu에서 Grafana 설치 및 보안 설정 방법 튜토리얼에 방문하세요. 처음 네 단계만 완료하면 됩니다.

- 완전히 등록된 도메인 이름이 드롭เล็ต에 포인트되어야 합니다. 이 튜토리얼에서는

your_domain을 전반적으로 사용하고 Grafana 필수 조건과 같은 도메인 이름을 참조합니다. 도메인 이름은 Namecheap에서 구매하거나 Freenom에서 무료로 얻을 수 있으며, 선택한 도메인 등록자를 사용할 수도 있습니다.

스텝 1 – Kafka 보안 프로토콜 설정

Kafka의 기본 설정에서는 모든 사용자가 요청의 Origin를 확인하지 않고 connected하도록 허용합니다. 这意味着您的集群默认对所有人开放。虽然这对于测试来说是可以的,因为它减少了本地机器和私有安装的维护负担,但是生产环境和面向公众的Kafka安装必须启用安全特性以防止未授权的访问。

이 단계에서는 Kafka 브로커를 TLS 암호화를 사용하여 브로커와 CONSUMER 간의 通信을 securing하고, SASL을 인증 프레임웍으로 集群に接続하는 것을 인증하기 위해 셋팅 할 것입니다.

TLS cerificate and Stores

TLS를 세팅하기 위해 필요한 cerificate and keys를 생성하기 위해 Confluent Platform Security Tools 저장소의 script를 사용하고, 첫 번째로 다음 명령어를 실행하여 主页 디렉터리에 clone 합니다.

그 다음 이 곳으로 Navigate하여:

스크립트의 이름은 kafka-generate-ssl-automatic.sh입니다. 이 스크립트는 국가, 주, 조직 및 도시를 이를 환경 변수로 제공하여야 합니다. 이러한 パラメーター는 Cerfiticate를 생성하는 데 사용되며, 그 내용은 중요하지 않습니다. 또한 암호를 제공해야 합니다. 이 암호는 생성되는 Java 신뢰 및 키 스토어를 보호하는 데 사용됩니다.

다음과 같은 명령어를 실행하여 필요한 환경 변수를 설정하십시오. your_tls_password을 자신의 원하는 값으로 대체하십시오.

기억하십시오, PASSWORD는 적어도 6자리 이상이어야 합니다.

스크립트에 실행 권한을 赋予了하기 위해 다음 명령어를 실행하십시오:

그러다가 필요한 파일을 생성하기 위해 스크립트를 실행하십시오:

많은 출력이 나ます. 완료되면 디렉터리의 파일을 목록에 기록합니다:

출력은 다음과 같은 것을 보여야 합니다:

Cerfiticate, trust, 및 key store가 성공적으로 생성되었음을 확인할 수 있습니다.

Kafka for TLS and SASL 구성

이제 TLS 암호화를 사용하기 위한 필요한 파일을 가지고 있으므로, Kafka를 이를 사용하여 사용자를 인증하는 SASL을 설정합니다.

config/kraft folDER 안에 server.properties 파일을 수정하시오. 前提사항 중 하나로 HomE directory 의 kafka 目录下에 설치하셨습니다. server.properties 파일을 editing 하기 위해서는 다음과 같이 실행하시오:

주요 設定 파일을 오픈하십시오:

nano config/kraft/server.properties

다음과 같은 行을 찾습니다:

다음과 같이 수정하십시오. PLAINTEXT를 BROKER로 替換하십시오:

次に listener.security.protocol.map 行을 찾습니다:

BROKER를 SASL_SSL에 매핑하기 위해 값에 이전 정의를 앞에 붙인다:

BROKER 에이리스를 리스너에 사용한 정의를 추가하고 SASL_SSL에 매핑했습니다. 이것은 SSL(TLS의 이전 이름)과 SASL를 모두 사용할 것을 의미합니다.

다음으로 파일의 끝으로 가서 다음 行을 추가합니다.

먼저 생성된 신뢰 및 키 스토어의 위치와 암호를 정의합니다. 您는 ssl.client.auth 매개 변수를 required로 설정하여 Kafka가 유효한 TLS 인증서를 제시하지 않는 모든 연결을 허용하지 않도록 지시합니다. 그 다음 SASL 기계식을 PLAIN로 설정하여 其를 활성화합니다. PLAIN는 PLAINTEXT와 다르게 암호화된 연결의 사용을 필요로하며, 두 者의 기반은 사용자 이름과 암호 인증정보의 조합입니다.

마지막으로 StandardAuthorizer를 인가자 claass로 설정합니다. 이것은 멀티 克罗诺斯에서 shortly crean 할 예정입니다. 그 다음 allow.everyone.if.no.acl.found 매개 변수를 false로 설정하여 적절한 인증정보를 갖지 않은 연결에 대한 接入를 제한합니다. 또한 admin 사용자를 슈퍼유저로 표시하여 克罗诺斯 내에서 관리 작업을 수행하는 至少 한 명의 인스턴스가 있어야 합니다.

이전 섹션에서 스크립트에 전달한 암호로 your_tls_password를 대체하고, 그 다음 파일을 저장하고 닫으세요.

Kafka를 설정하셨으면 Connector를 만들 수 있는 허용된 인증정보를 정의하는 파일을 생성해야 합니다. Kafka는 인증 workflow를 구현하기 위한 프레임워크로 Java Authentication and Authorization Service (JAAS)를 지원하고 JAAS 형식의 인증정보 정의를 받습니다.

이를 config/kraft 하위에 있는 kafka-server-jaas.conf 파일에 저장할 것입니다. 이를 편집하기 위해서는 다음 명령어를 실행하세요:

次の行을 추가하세요:

이 username와 password는 다양한 노드가 있는 클러스터内에서 인tra-broker 통신에 사용되는 주요 인증정보를 정의합니다. user_admin 行은 이름이 admin하고 암호가 admin인 사용자를 정의하며 이 사용자는 외부から 브로커로 연결할 수 있습니다. 변경 후에 파일을 저장하고 닫으세요.

Kafka는 주요 구성에 supplementing 하는 것으로 kafka-server-jaas.conf 파일을 알아야 합니다. 이를 의미하기 위해 kafka systemd 서비스 구성을 수정하고 그 참조를 전달해야 합니다. 다음 명령어를 실행하여 서비스를 편집하세요:

`–full`을 사용하면 서비스의 compete contents를 보실 수 있습니다. ExecStart 行을 找到하세요:

이를 위해 위에서부터 다음 行을 추가하세요. 이가 다음과 같게 보입니다:

이와 같이 설정하면 config 파일에서 java.security.auth.login.config 매개변수를 JAAS config 파일의 경로로 설정하여 주 Kafka 설정 파일에서 분리합니다. 작업이 끝나면 파일을 저장하고 닫습니다. 다음 명령어를 실행하여 서비스 정의를 다시 로드합니다:

그런 다음, Kafka를 재시작합니다:

이제 Kafka 설치에 TLS 암호화와 SASL 인증을 모두 설정했으며, 제공된 콘솔 스크립트로 연결하는 방법을 이제 배울 것입니다.

단계 2 – 보안된 클러스터에 연결하기

이 단계에서는 제공된 콘솔 스크립트와 JAAS config 파일을 사용하여 보안된 Kafka 클러스터에 연결하는 방법을 배울 것입니다.

제공된 토픽 조작, 메시지 생산 및��費 스크립트는 내부적으로 자바를 사용하며 따라서 신뢰 키 저장소의 위치와 SASL 자격 증명을 포함한 JAAS 구성을 받아들입니다.

이 구성을 홈 디렉토리에 있는 client-jaas.conf 파일에 저장합니다. 파일을 생성하고 편집하려면 다음과 같이 합니다:

다음 줄을 추가합니다:

프로토콜을 SASL_SSL로 설정하고, 생성한 키 및 신뢰 저장소의 경로와 암호를 제공합니다. 그런 다음, SASL 메커니즘을 PLAIN으로 설정하고, 사용자 admin의 자격 증명을 제공합니다. 초기 스크립트가 실행된 머신의 호스트 이름을 인증서 엔드포인트로 설정하므로 올바른지 않을 수 있으므로, ssl.endpoint.identification.algorithm 매개변수를 명시적으로 지웁니다.

your_tls_password를 올바른 값으로 대체한 후, 파일을 저장하고 닫습니다.

이 파일을 스크립트에 전달하려면 --command-config 매개변수를 사용할 수 있습니다. 클러스터에서 새로운 토픽을 생성해 보세요. 다음 명령어를 사용합니다:

명령어가 성공적으로 실행되어야 합니다:

생성되었는지 확인하려면, 클러스터의 모든 토픽을 나열하려면 다음을 실행합니다:

출력에서 new_topic이 존재하는 것을 보여줄 것입니다:

이 섹션에서는 Kafka 설치를 트래픽의 TLS 암호화와 SASL을 사용하여 사용자 이름과 암호의 조합으로 인증하도록 구성했습니다. 이제 Prometheus를 사용하여 Kafka 메트릭을 JMX를 통해 내보내는 방법을 배워보겠습니다.

Step 3 – Prometheus를 사용하여 Kafka JMX 메트릭 모니터링

이 섹션에서는 Kafka metrics을 Prometheus로 수집하고, Grafana에서 쿼리 가능하게 만들 것입니다. 이를 위해 Kafka를 위한 JMX eks포터를 세팅하고, 그를 Prometheus와 연결할 것입니다.

[Java Management Extensions (JMX)는 자바 应用程序에 대한 프레임웍이며, 開発자가 standardized format에서 일반적인 및 사용자 정의 metrics를 应用程序 运行为에서 수집할 수 있는 기능을 제공합니다. 因為 Kafka는 자바로 기술되었으며 JMX 프로토콜을 지원하고 자신의 사용자 정의 metrics를 그에 의해 노출합니다. 이러한 metrics는 주로 주제와 브로ker의 상태와 같습니다.

Kafka와 Prometheus 설정

이전에 하는 것 전에, Prometheus를 설치하는 必要가 있습니다. Ubuntu 머신에서는 apt을 사용할 수 있습니다. 그렇다면 다음과 같이 저장소를 갱신하십시오.

그 다음, Prometheus을 설치합니다.

다른 플랫폼에서는 사이트에서 설치 지침을 따라야 합니다. 공식 웹사이트에서 해주십시오.

설치 후, Prometheus에 Kafka 설치에 JMX exporter 라이브러리를 추가해야 합니다. 릴리즈 페이지로 이동하여 이름에 javaagent가 포함된 최신 릴리즈를 선택합니다. 이 글을 작성하는 시점에서 최신 доступ한 버전은 0.20.0이었습니다. 다음 명령어를 사용하여 Kafka가 설치된 libs/ 디렉토리에 다운로드합니다:

JMX exporter 라이브러리는 이제 Kafka에서 인식될 것입니다.

Exporter를 활성화하기 전에, Prometheus에 보고할 메트릭을 정의해야 하며, 해당 구성은 Kafka 설치의 config/ 디렉토리에 있는 jmx-exporter.yml 파일로 저장합니다. JMX exporter 프로젝트는 적절한 기본 구성을 제공하므로, 다음 명령어를 실행하여 Kafka 설치의 config/ 디렉토리에 jmx-exporter.yml로 저장합니다:

다음으로, exporter를 활성화하기 위해 Kafka systemd 서비스를 수정해야 합니다. KAFKA_OPTS 환경 변수에 exporter와 그 구성을 포함시켜야 합니다. 서비스를 편집하려면 다음 명령어를 실행합니다:

Environment 줄을 다음과 같이 수정합니다:

여기서, -javaagent 인수를 사용하여 JMX exporter를 구성으로 초기화합니다.

수정이 끝나면 파일을 저장하고 닫고, 다음 명령어를 실행하여 Kafka를 재시작합니다:

일분 후, JMX exporter가 실행 중인지 확인하기 위해 포트 7075이 사용 중인지 질의합니다:

이 줄은 포트 7075가 Kafka 서비스에 의해 시작된 Java 프로세스에 의해 사용 중임을 보여줍니다. 이는 JMX exporter를 참조합니다.

이제 Prometheus를 설정하여 내보낸 JMX 메트릭을 감시합니다. 주요 구성 파일은 /etc/prometheus/prometheus.yml에 위치하고 있으므로 편집할 수 있도록 엽니다:

다음 줄을 찾으십시오:

scrape_configs 아래에, Prometheus가 감시할 엔드포인트를 지정하는 곳에 Kafka 메트릭을 스크랩할 새로운 섹션을 추가합니다:

`kafka` 작업은 하나의 대상을 가지고 있으며, 이는 JMX eksporters 엔드포인트로 지정되어 있습니다.

`your_domain`을 자신의 도메인 이름으로 바꿔주고 이 ファイル을 저장하고 닫으십시오. 그 다음, 다음과 같이 프로메etheus를 다시 시작하십시오:

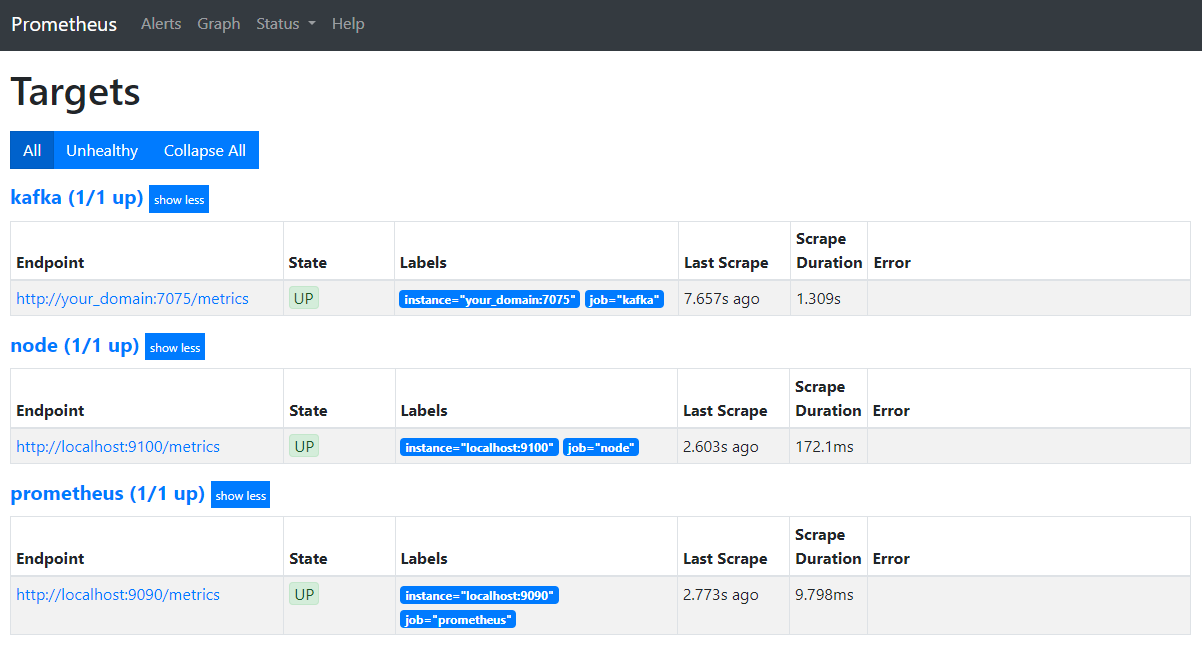

브라우저에서 도메인의 9090 포트로 이동하여 Prometheus UI를 사용할 수 있습니다. Status 下面에 Targets를 클릭하여 작업 목록을 볼 수 있습니다:

프로메etheus가 kafka 작업을 인정하고 그의 지표를 스크래핑하는 것을 알 수 있습니다. 이제 Grafana로 이를 이용하는 방법을 배울 것입니다.

Grafana에서 메트릭 질의

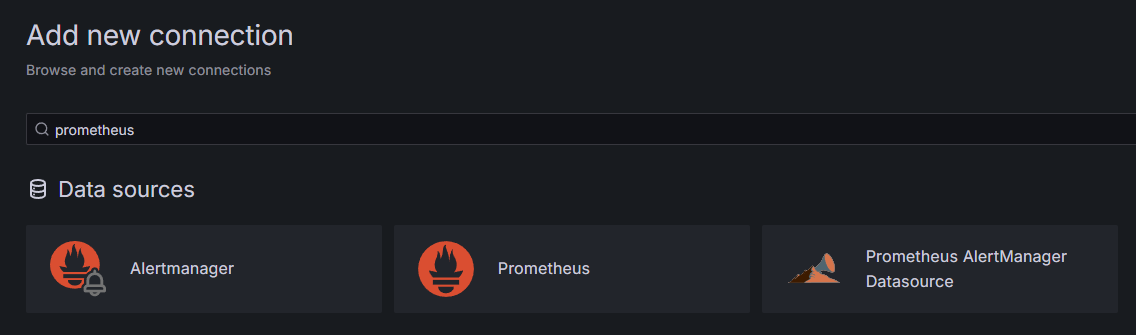

필수 조건의 일부로, Droplet에 Grafana를 설치하고 your_domain에서 노출시켰습니다. 브라우저에서 이동하고, 사이드バー의 연결 아래에 있어서 새 연결 추가를 누르고, 검색 필드에 프로메테우스를 입력하세요.

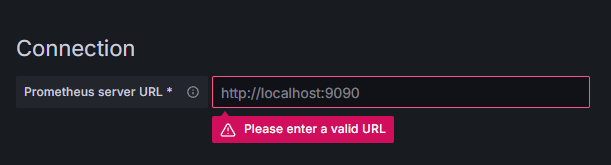

프로메테우스를 누르고, 오른쪽 위의 새 데이터 소스 추가 버튼을 클릭하세요. 프로메테우스 인스턴스의 주소를 입력하라는 요청을 받게 됩니다:

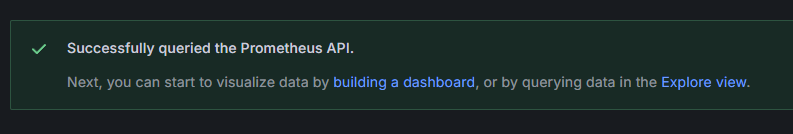

http://your_domain_name:9090를 입력하고, 실제 도메인 이름으로 교체한 후 아래로 스크롤 다운하고 저장 및 테스트를 누르세요. 성공 메시지를 받아야 합니다:

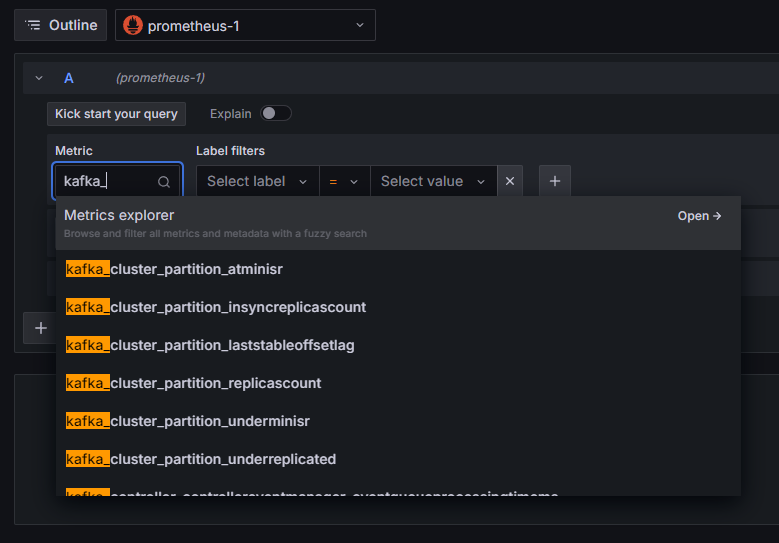

프로메테우스 연결이 Grafana에 추가되었습니다. 사이드バ러의 탐색를 눌러서, 메트릭을 선택하라는 prompt가 뜨게 됩니다. kafka_를 입력하면 클러스터와 관련된 모든 메트릭을 나열할 수 있습니다,如下所示:

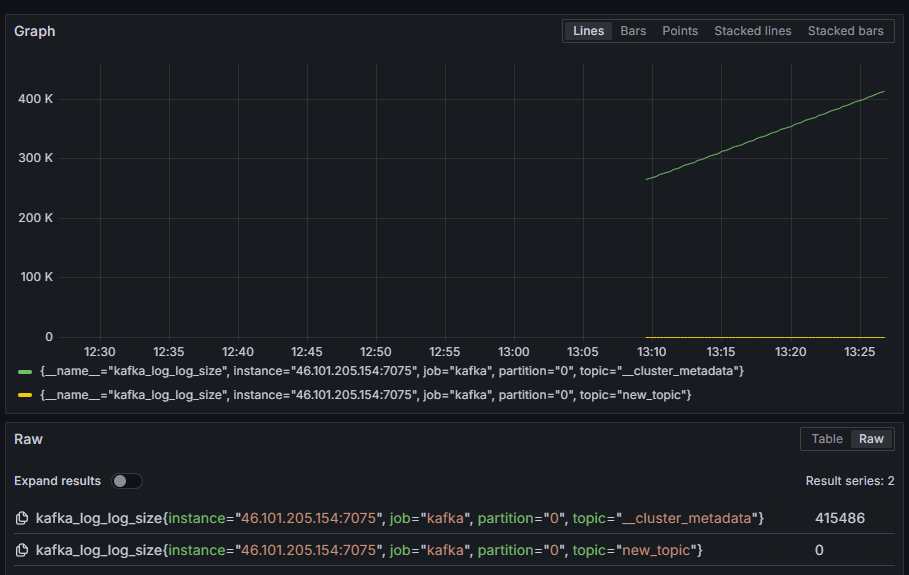

예를 들어, 파티션ごと 디스크에 있는 내부 로그의 크기를 보여주는 kafka_log_log_size 메트릭을 선택하고, 오른쪽 위 구석의 쿼리 실행을 누릅니다. 각 사용 가능한 주제에 대해 시간이 지남에 따라 결과 크기를 볼 수 있습니다:

이 단계에서는 Kafka가 제공하는 JMX 메트릭을 내보내기 설정하고 Prometheus를 이를 수집할 수 있도록 구성했습니다. 그런 다음, Grafana에서 Kafka 메트릭에 대한 쿼리를 실행하기 위해 이에 연결했습니다. 이제 웹 인터페이스를 사용하여 Kafka 클러스터를 관리하는 방법을 배울 것입니다.

Step 4 – AKHQ를 사용하여 Kafka 클러스터 관리

이 단계에서는 Kafka 클러스터를 관리하는 웹 앱인 AKHQ를 설정하고 사용하는 방법을 배울 것입니다. 이 앱을 사용하면 토픽, 파티션, 컨슈머 그룹 및 구성 매개변수를 나열하고 조작할 수 있으며, 단일 위치에서 토픽에서 메시지를 생성하고��费할 수 있습니다.

실행 파일과 그 구성을 akhq라는 디렉토리에 저장하겠습니다. 홈 디렉토리에 이를 생성하기 위해 다음 명령을 실행합니다:

이 디렉토리로 이동합니다:

브라우저에서 공식 릴리스 페이지에 방문하여 최신 릴리스의 JAR 파일 링크를 복사합니다. 이 글 작성 시 최신 버전은 0.24.0였습니다. 이를 홈 디렉토리에 다운로드하기 위해 다음 명령을 실행합니다:

이제 AKHQ를 다운로드했으며 클러스터에 연결하기 위한 구성을 정의할 준비가 되었습니다. 이를 akhq-config.yml 파일에 저장하겠습니다. 이를 생성하고 편집하기 위해 다음 명령을 실행합니다:

다음 줄들을 추가합니다:

기본적인 AKHQ 구성입니다. localhost:9092에 있는 하나의 클러스터를 지정하고, 해당하는 SASL 및 TLS 파라미터를 지정하고 있습니다. 여러 클러스터를 동시에 지원하기도 합니다. 원하는만큼 많은 연결을 정의할 수 있기 때문입니다. 이를 통해 AKHQ는 Kafka 관리에 매우 다재다능합니다. 작업이 끝나면 파일을 저장하고 닫으십시오.

다음으로, 배경에서 AKHQ를 실행하기 위한 systemd 서비스를 정의해야 합니다. systemd 서비스는 일관되게 시작되고, 중지되고, 재시작할 수 있습니다.

서비스 구성을 code-server.service 파일에 저장하십시오. 이 파일은 /lib/systemd/system 디렉토리에 저장됩니다. systemd가 자신의 서비스를 저장하는 곳입니다. 텍스트 편집기를 사용하여 생성하십시오:

다음 줄들을 추가하십시오:

먼저 서비스 설명을 지정합니다. 그런 다음, [Service] 섹션에서 서비스 유형을 정의하고 (simple은 명령어가 단순히 실행되어야 한다는 의미입니다), 실행될 명령어를 제공합니다. 또한, 실행되는 사용자는 kafka이며, 서비스가 종료되면 자동으로 재시작되어야 한다고 지정합니다.

[Install] 섹션에서 systemd가 서버에 로그인할 때 이 서비스를 시작하도록 지정합니다. 작업이 끝나면 파일을 저장하고 닫으십시오.

서비스 구성을 로드하기 위해 다음을 실행하십시오:

AKHQ 서비스를 시작하려면 다음 명령어를 실행하십시오:

그런 다음, 상태를 확인하여 올바르게 시작되었는지 확인하십시오:

출력은 다음과 같아야 합니다:

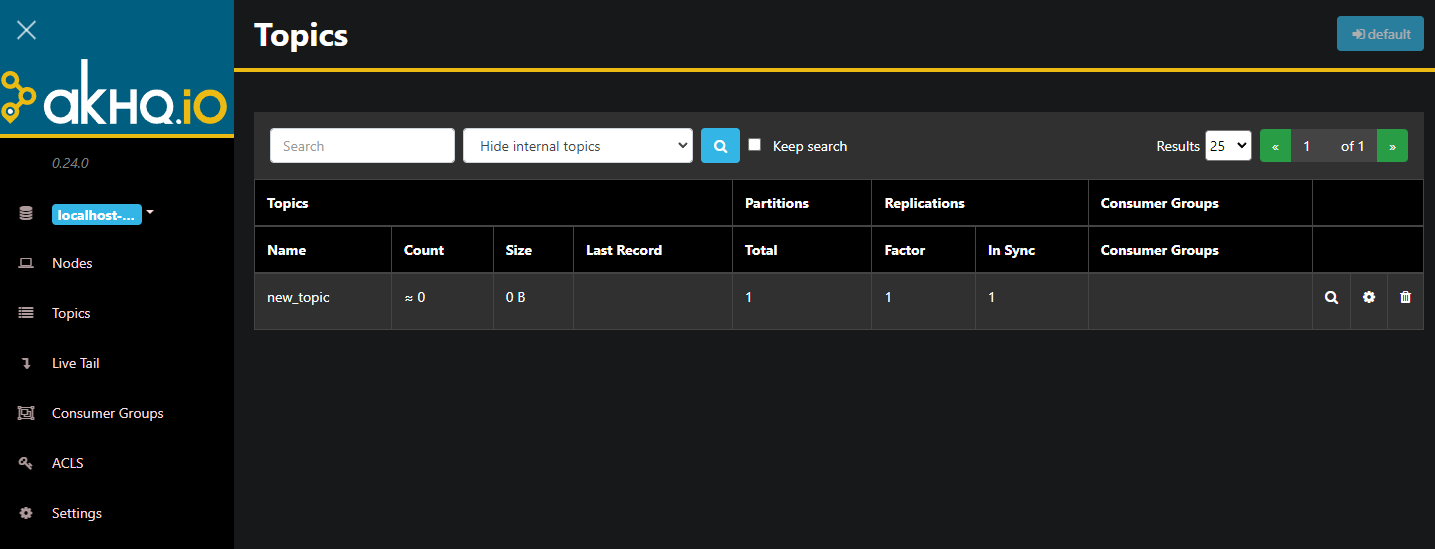

AKHQ는 현재 배경进程中에서 실행되고 있습니다. 기본적으로 8080 포트에 노출되어 있습니다. 브라우저에서 도메인과 이 포트를 이용하여 접근할 수 있습니다. 기본 ビュー를 보여 주며 주제 목록을 보여줍니다.:

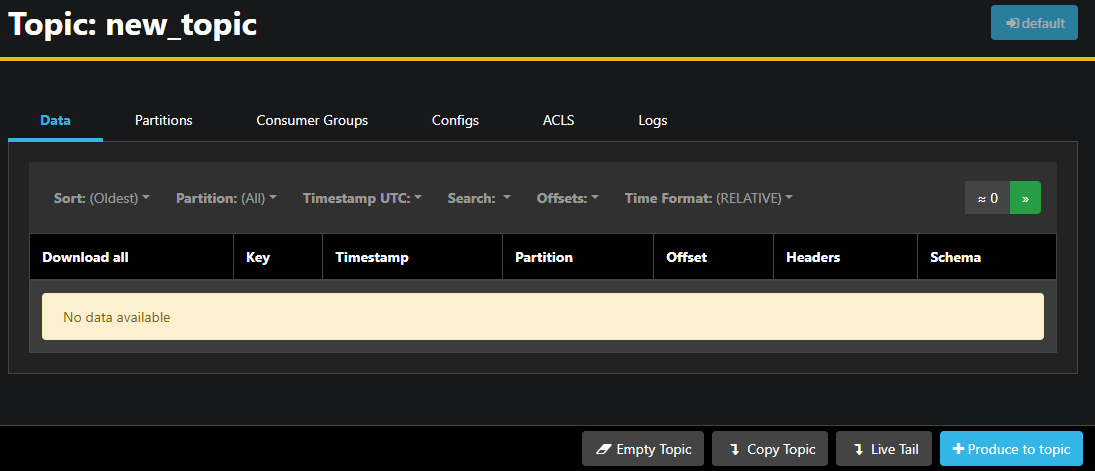

테이블에 있는 주제의 경로를 ダブル 클릭하여 상세 보기로 이동할 수 있습니다.:

AKHQ를 사용하여 주제의 메시지를 보며, 分区, 컨슈머 그룹 및 그들의 설정을 볼 수 있습니다. 하단 오른쪽의 buttons를 사용하여 주제를 비우거나 복사할 수 있습니다.

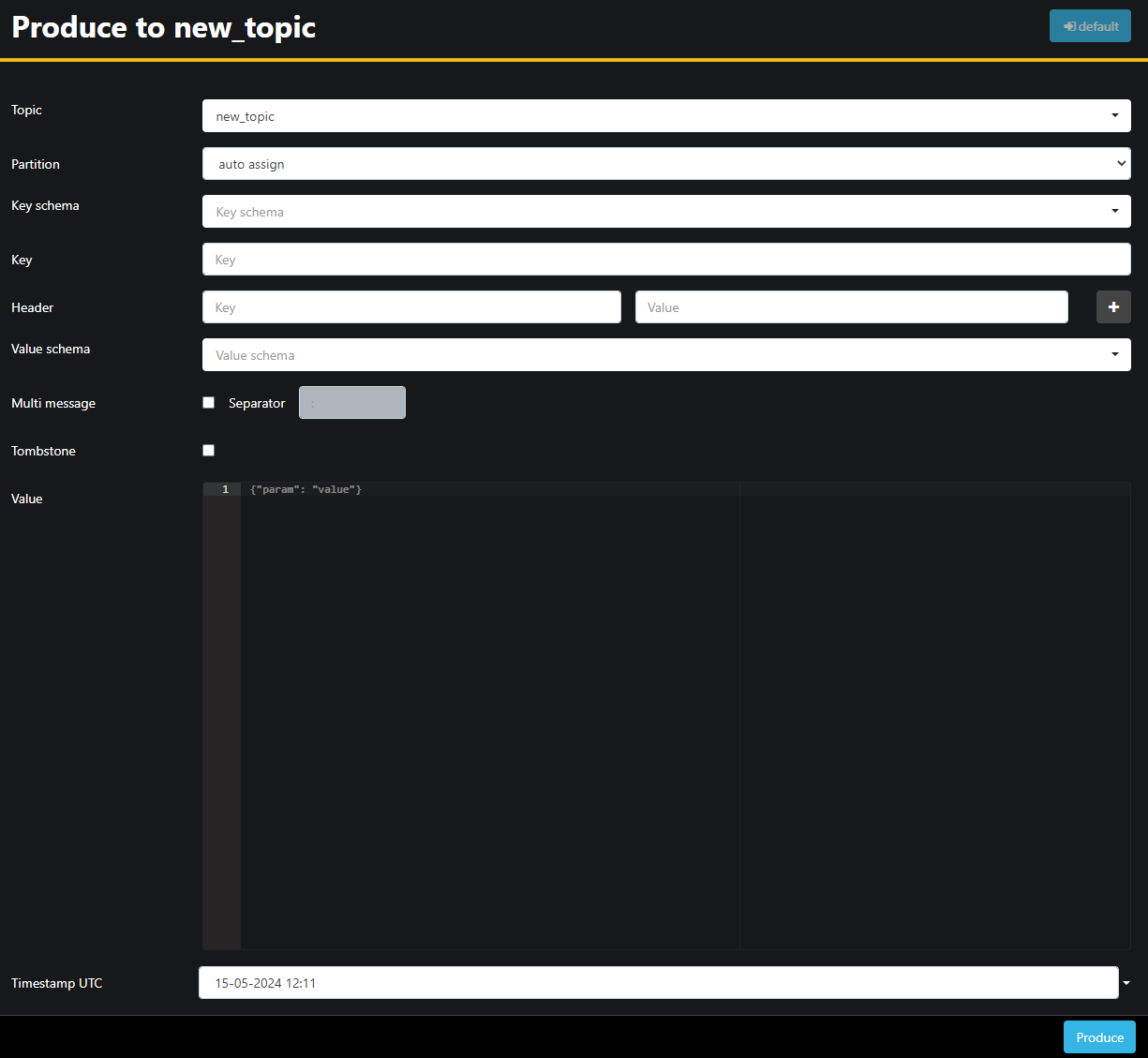

`new_topic` 주제가 비어 있으므로 Produce to topic 버튼을 눌러 새 메시지의 パラ미터 선택 인터페이스를 여는 것입니다.:

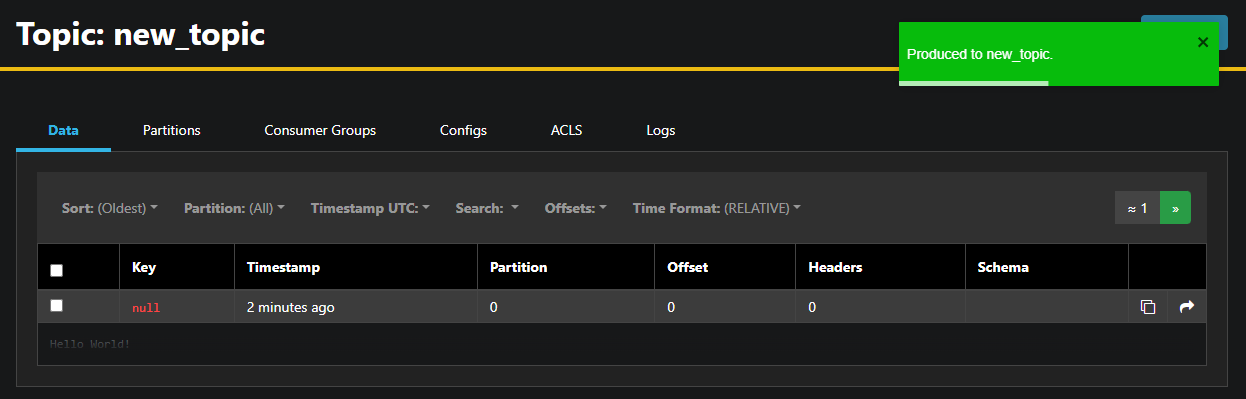

AKHQ가 자동으로 주제 이름을 채워 줍니다. Value 필드에 `Hello World!`을 입력하고 Produce를 눌러 메시지를 Kafka로 보냅니다. 그 后来, Data 탭에서 이를 볼 수 있습니다.:

메시지의 내용이 非常大的할 수 있으므로 AKHQ는 첫 行만 보여줍니다. compete 메시지를 보려면 行の暗闇 영역을 탭하여 보여줍니다.

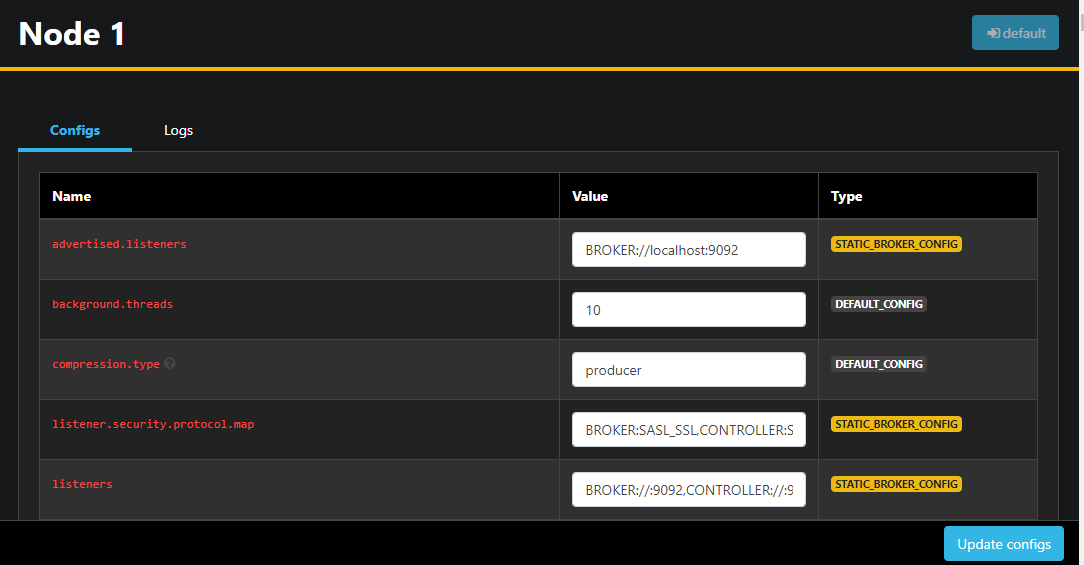

왼쪽 사이드 모듈에서 Nodes를 눌러 クラス터의 브로ker를 목록 조회할 수 있습니다. 현재 클러스터는 한 노드로 구성되어 있습니다.:

노드를 ダブル 클릭하여 설정을 변경하는 것을 위한 개별 설정 화면을 여는 것입니다.

일万吨 변경 사항을 마친 후, 하단 오른쪽의 Update configs tab를 눌러 적용할 수 있습니다. 마찬가지로, 어느 话题의 설정을 보고 수정할 수 있습니다.

이 섹션에서는, Kafka 노드와 话题를 원격 지정하여 관리하고 모니터링하기 위한 사용하기 쉬운 UI를 제공하는 AKHQ를 세팅했습니다. 이 어플리케이션은 话题에 消息을 생성하고 소비하고, 话题과 노드의 설정 파라미터를 现场에서 갱신할 수 있습니다.

결론

이 튜토리얼에서는 Kafka 설치를 TLS를 사용하여 암호화하고 SASL을 사용하여 사용자 인증하는 것을 통해 보호하였습니다. 또한 Prometheus를 사용하여 지표를 eksポrt하고 Grafana에서 이를 的可視화했습니다. 그리고 AKHQ, Kafka クラスタ를 관리하는 웹 응용을 사용方法을 배웠습니다.

著者는 Apache Software Foundation을 Write for DOnations 프로그램 의 기부 대상으로 선택했습니다.

Source:

https://www.digitalocean.com/community/developer-center/how-to-secure-and-monitor-kafka