LM Studioは、Linuxマシン上で大きな言語モデル(LLMs)をダウンロード、インストール、およびローカルに実行することができる、ユーザーフレンドリーなデスクトップアプリケーションです。

LM Studioを使用することで、雲上のAIモデルに関連した制約とプライバシーの懸念から解放されますが、また熟悉なChatGPTのようなインターフェースを楽しめます。

この記事では、LM StudioをLinux上でAppImage形式でインストールする方法を説明し、特定のLLMモデルをローカルに実行する例を提供します。

システム要件

Linux上でLM Studioを実行するための最小限のハードウェアとソフトウェアの要件は以下の通りです:

- NVIDIAまたはAMDのグラフィックカードを使用して、少なくとも8GBのVRAMが必要です。

- AVX2に準拠するプロセッサと少なくとも16GBのRAMが必要です。

LM StudioをLinuxにインストールする

始めるために、公式ウェブサイトまたはリポジトリから最新のLM Studio AppImageをダウンロードする必要があります。

次に、AppImageをダウンロードした後、実行可能にする必要があり、AppImageの内容を抽出する必要があります。これにより、squashfs-rootという名前のディレクトリに展開されます。

chmod u+x LM_Studio-*.AppImage ./LM_Studio-*.AppImage --appimage-extract

今度は、抽出されたsquashfs-rootディレクトリに移動し、アプリケーションを安全に実行するために必要なヘルパーバイナリーファイルchrome-sandboxに適切な permissions を設定します。

cd squashfs-root sudo chown root:root chrome-sandbox sudo chmod 4755 chrome-sandbox

今、LM Studioアプリケーションを、抽出されたファイルから直接実行することができます。

./lm-studio

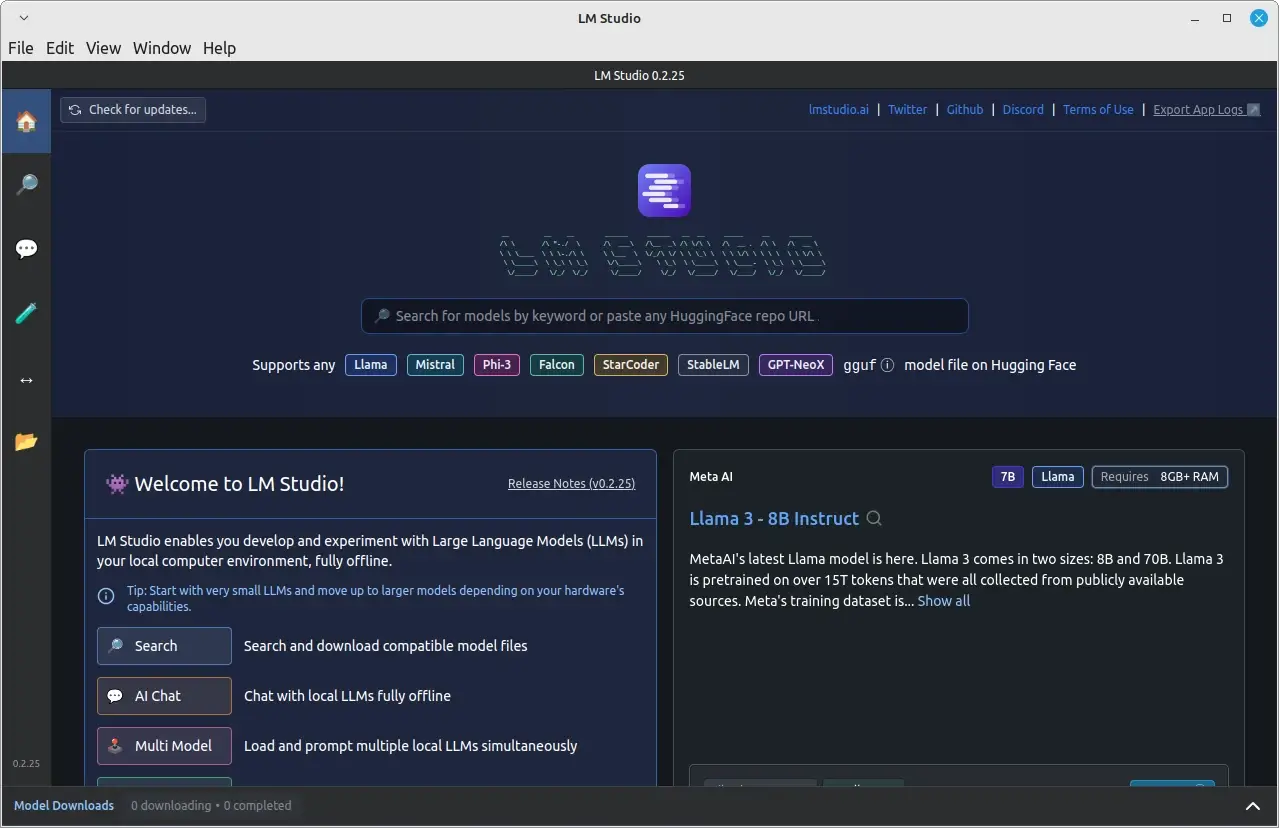

それで完了です!LM Studioは、Linuxシステム上にインストールされ、ローカルのLLMを探索して実行することができます。

Linuxでローカルに言語モデルを実行する

LM Studioのインストールと実行に成功した後、言語モデルをローカルに実行するためにそれを使用することができます。

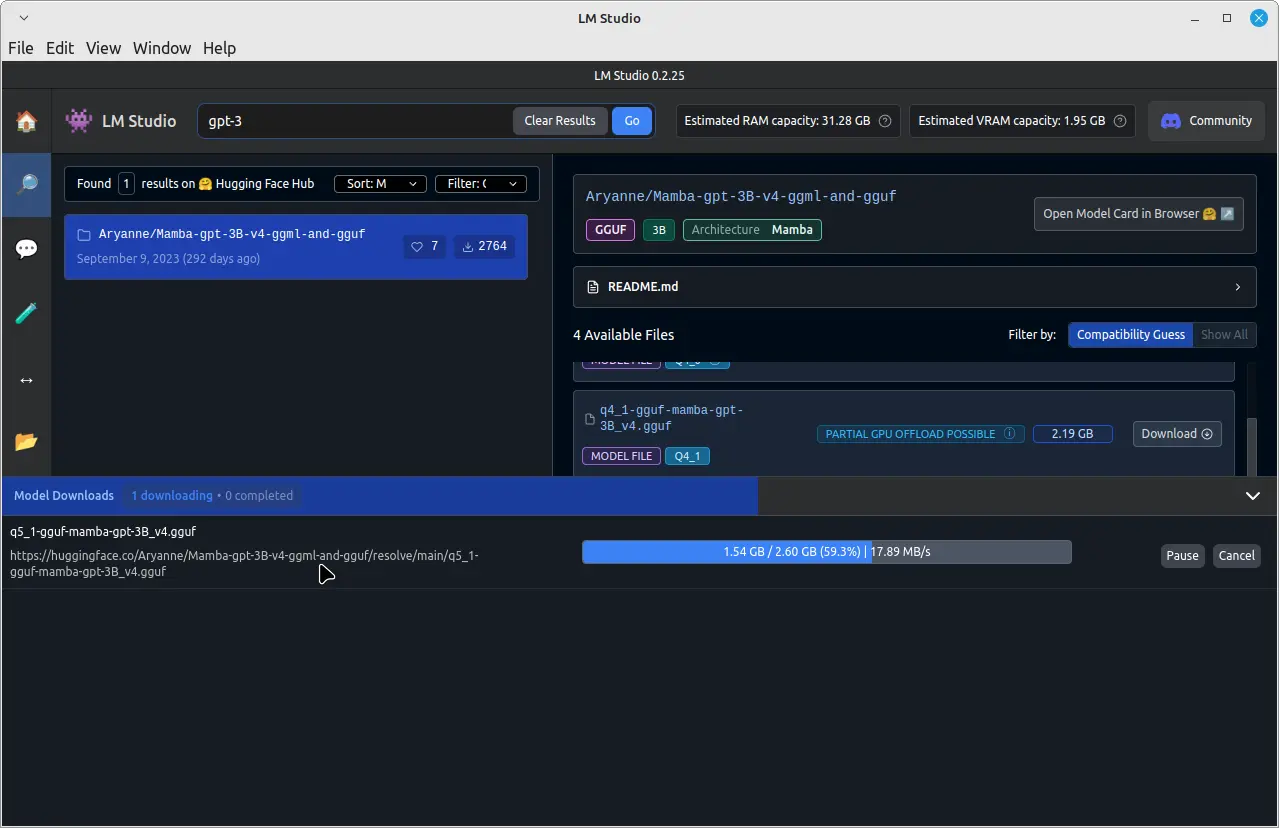

たとえば、GPT-3という名前の事前トレーニングされた言語モデルを実行するには、最上部の搜索バーに click し、「GPT-3」と入力し、ダウンロードします。

ダウンロードが完了すると、左側の画面で「Chat」タブをクリックします。 「Chat」タブで、最上部の下拉メニューをクリックして、ダウンロードしたGPT-3モデルを選択します。

それで、GPT-3モデルと会話を始めることができます。

会話ウィンドウの下部の入力フィールドにメッセージを入力すると、GPT-3モデルがあなたのメッセージを処理し、トレーニングに基づいて回答を提供します。

また、

Linuxシステム上にLM StudioをAppImage形式でインストールすることで、クラウドベースのサービスを依存せずに、簡単に大きな言語モデルをローカルにダウンロード、インストールして実行することができます。

これにより、高度なAIモデルの利点を享受する同时に、データとプライバシーのコントロールを強化することができます。LLMsをダウンロードしてLM Studioを使用して実行する際には、知的財産権を常に尊重し、使用条件に従うようにしてください。