LM Studio est une application de bureau facile à utiliser qui vous permet de télécharger, installer et exécuter des grands modèles de langue (LLMs) locaux sur votre machine Linux.

En utilisant LM Studio, vous pouvez échapper aux limitations et aux inquiétudes de confidentialité associées aux modèles d’IA basés dans le cloud, tout en profitant d’une interface similaire à ChatGPT.

Dans cet article, nous vous guiderons à travers l’installation de LM Studio sous Linux en utilisant le format AppImage, et fournirons un exemple de l’exécution d’un LLM spécifique localement.

Reqûetes systèmes

Les exigences minimales en matériel et logiciel pour l’exécution de LM Studio sous Linux sont :

- Carte graphique NVIDIA ou AMD avec au moins 8Go de VRAM.

- Un processeur compatible avec AVX2 et au moins 16Go de RAM sont requis.

Installation de LM Studio sous Linux

Pour commencer, vous devez télécharger la dernière version de LM Studio AppImage depuis le site officiel ou le dépôt.

Une fois l’AppImage téléchargé, vous devez le rendre exécutable et extraire le contenu de l’AppImage, qui se déploiera automatiquement dans un répertoire nommé squashfs-root.

chmod u+x LM_Studio-*.AppImage ./LM_Studio-*.AppImage --appimage-extract

Maintenant, navigatez vers le répertoire extrait squashfs-root et définissez les permissions appropriées pour le fichier chrome-sandbox, qui est un fichier binaire assistant dont l’application a besoin pour s’exécuter de manière sécurisée.

cd squashfs-root sudo chown root:root chrome-sandbox sudo chmod 4755 chrome-sandbox

Maintenant, vous pouvez exécuter l’application LM Studio directement à partir des fichiers extraits.

./lm-studio

C’est tout! LM Studio est maintenant installé sur votre système Linux, et vous pouvez commencer à explorer et à exécuter des ML locaux.

Exécution d’un Modèle de Langue Localement sous Linux

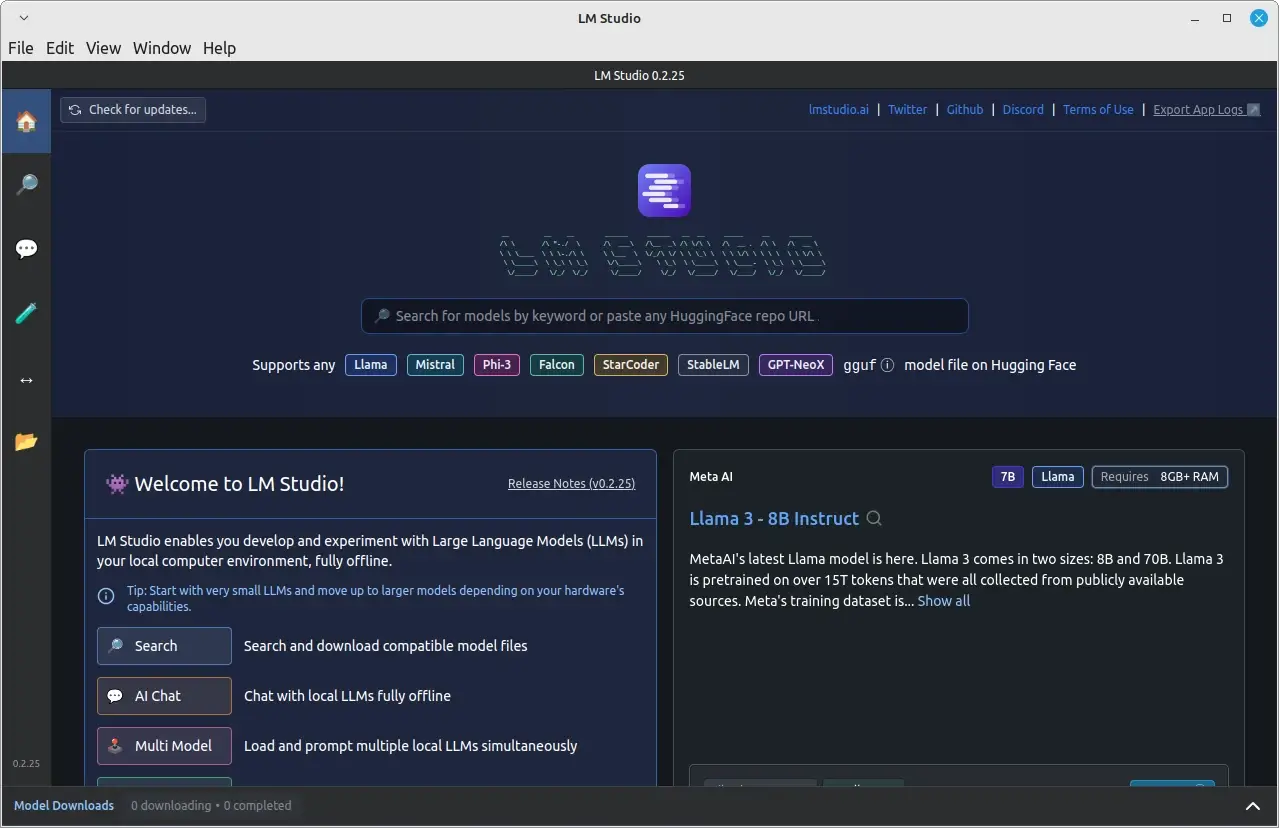

Après avoir installé et lancé LM Studio avec succès, vous pouvez commencer à l’utiliser pour exécuter des modèles de langue locaux.

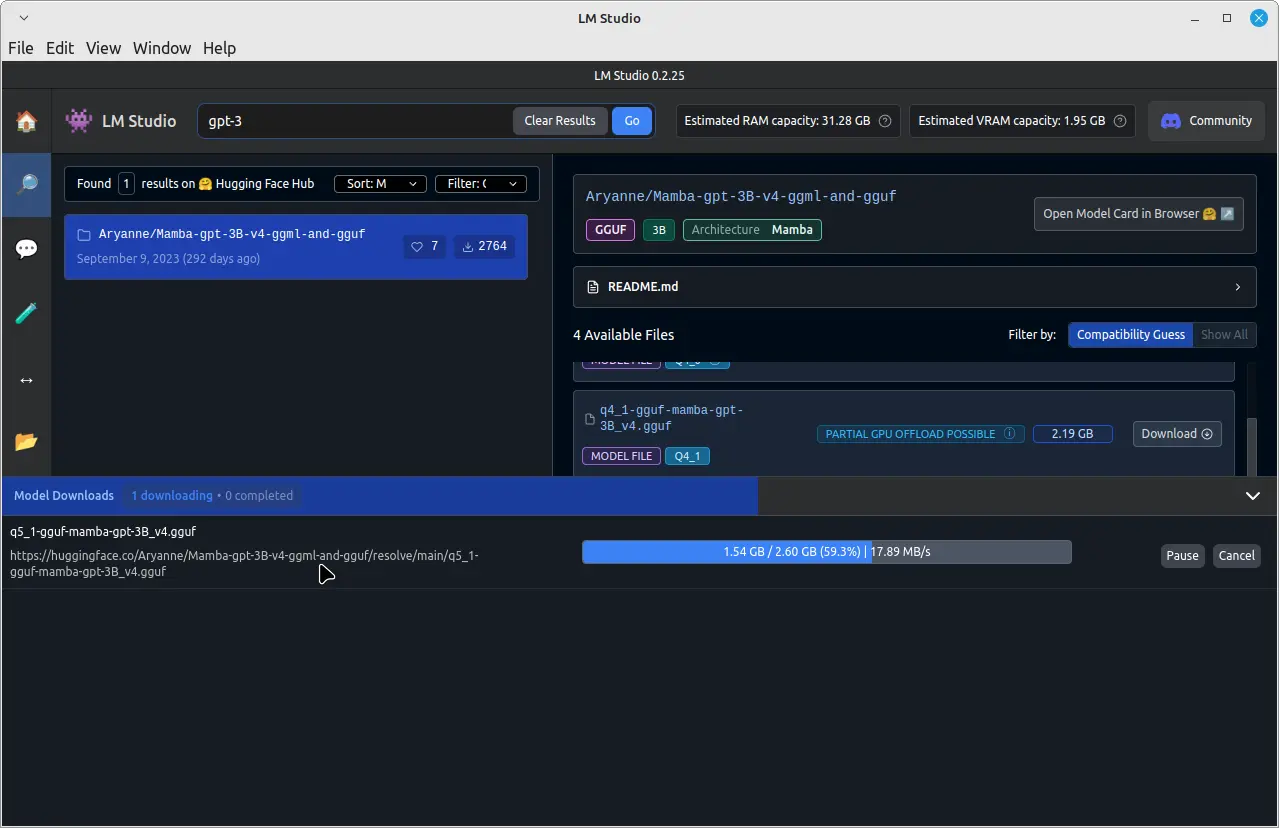

Par exemple, pour exécuter un modèle de langue pré-entraîné appelé GPT-3, cliquez sur la barre de recherche en haut et tapez “GPT-3” puis cliquez sur Télécharger.

Une fois le téléchargement terminé, cliquez sur l’onglet “Discuter” dans le panneau de gauche. Dans l’onglet “Discuter”, cliquez sur le menu déroulant en haut et sélectionnez le modèle GPT-3 téléchargé.

Vous pouvez maintenant commencer à discuter avec le modèle GPT-3 en tapant vos messages dans le champ d’entrée situé en bas de la fenêtre de discussion.

Le modèle GPT-3 traitera vos messages et fournira des réponses en fonction de son entraînement. N’oubliez pas que le temps de réponse peut varier en fonction de la hardware de votre système et de la taille du modèle téléchargé.

Conclusion

En installant LM Studio sur votre système Linux en utilisant le format AppImage, vous pouvez facilement télécharger, installer et exécuter des grands modèles de langue locaux sans dépendre de services basés sur le cloud.

Cela vous donne un meilleur contrôle sur vos données et votre privacy tout en vous permettant de profiter des avantages des modèles AI avancés. N’oubliez pas de toujours respecter les droits de propriété intellectuelle et de conformité aux termes d’utilisation pour les LLMs que vous téléchargez et exécutez avec LM Studio.