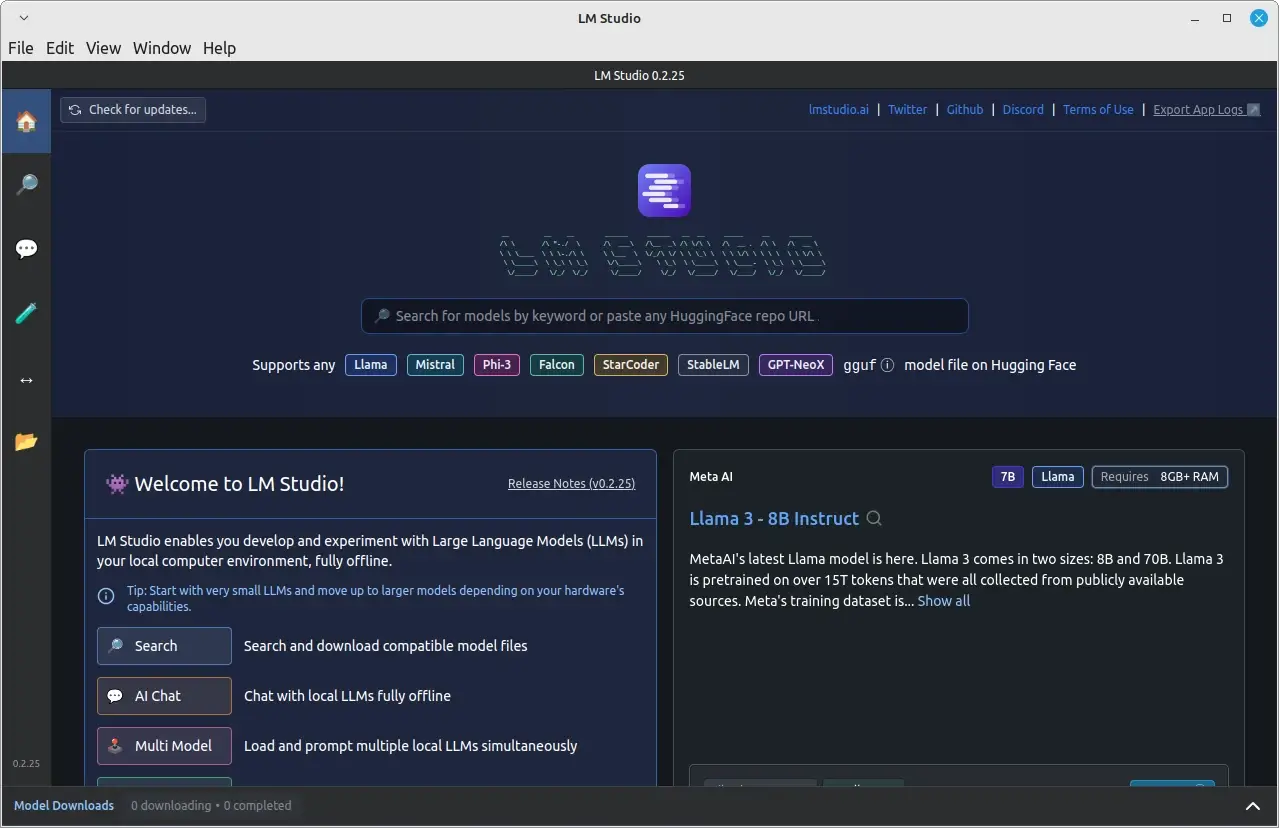

LM Studio es una aplicación de escritorio amigable con el usuario que le permite descargar, instalar y ejecutar grandes modelos de lenguaje (LLMs) localmente en su equipo Linux.

Usando LM Studio, puede librarse de las limitaciones y preocupaciones de privacidad asociadas con los modelos de IA en la nube, mientras aún disfruta de una interfaz familiar como ChatGPT.

En este artículo, le guiaremos a través de la instalación de LM Studio en Linux utilizando el formato AppImage, y le proporcionaremos un ejemplo de ejecución de un modelo de LLM específico localmente.

Requisitos del Sistema

Los requisitos mínimos de hardware y software para ejecutar LM Studio en Linux son:

- Un tarjeta de gráficos dedicada NVIDIA o AMD con al menos 8GB de VRAM.

- Se necesita un procesador compatible con AVX2 y al menos 16GB de RAM.

Instalando LM Studio en Linux

Para empezar, necesita descargar la última versión de LM Studio AppImage de la página web oficial o del repositorio.

Una vez descargado el AppImage, necesita hacerlo ejecutable y extraer los contenidos del AppImage, que se desplegará automáticamente en un directorio llamado squashfs-root.

chmod u+x LM_Studio-*.AppImage ./LM_Studio-*.AppImage --appimage-extract

Ahora vaya al directorio extraído squashfs-root y establezca las permisos apropiados para el archivo chrome-sandbox, que es un archivo binario de ayuda que la aplicación necesita para ejecutarse de manera segura.

cd squashfs-root sudo chown root:root chrome-sandbox sudo chmod 4755 chrome-sandbox

Ahora puede ejecutar directamente la aplicación LM Studio desde los archivos extraídos.

./lm-studio

¡Eso es todo! LM Studio ya está instalado en su sistema Linux, y puede comenzar a explorar y ejecutar modelos de lenguaje locales.

Ejecución de un Modelo de Lenguaje Localmente en Linux

Después de instalar y ejecutar correctamente LM Studio, puede empezar a usarlo para ejecutar modelos de lenguaje localmente.

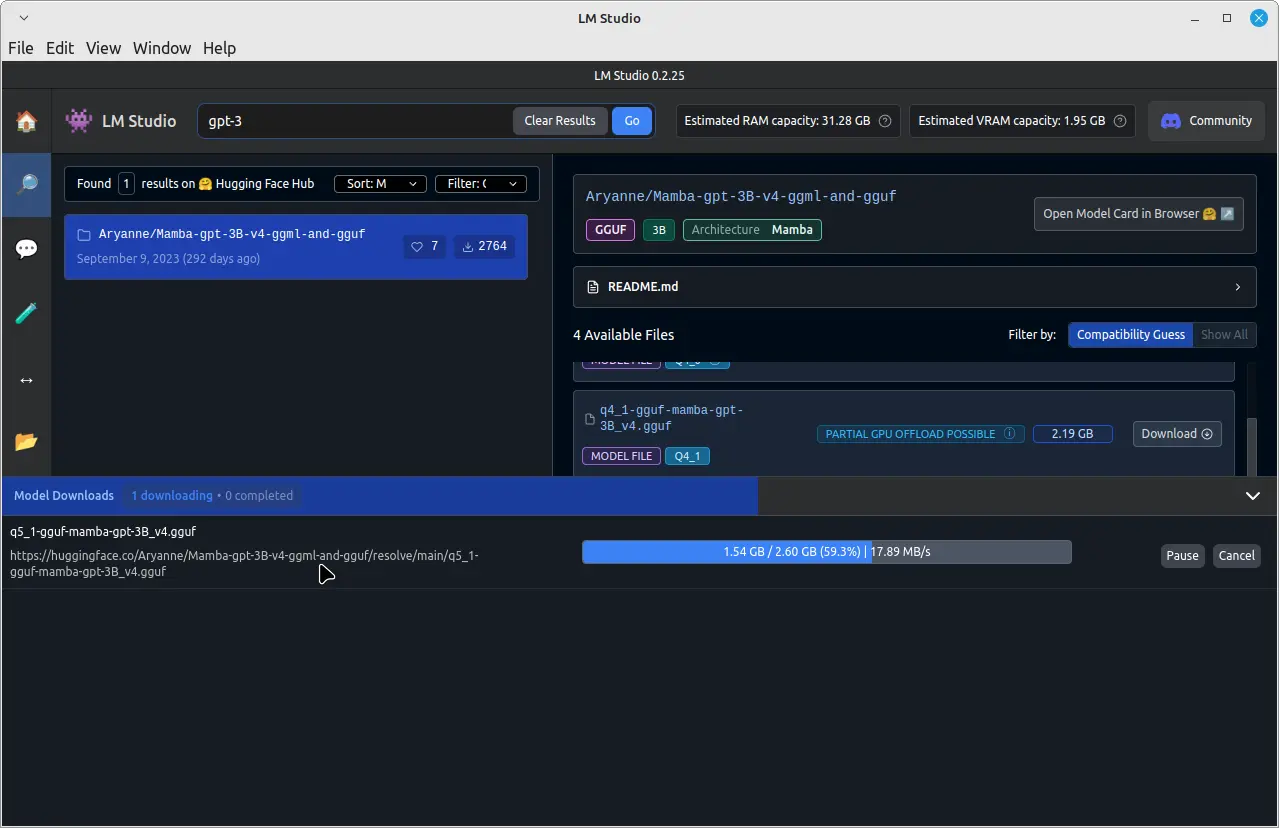

Por ejemplo, para ejecutar un modelo de lenguaje preentrenado llamado GPT-3, haga clic en la barra de búsqueda de arriba y escriba “GPT-3” y descárguelo.

Una vez finalizada la descarga, haga clic en la pestaña “Chat” en el panel izquierdo. En la pestaña “Chat”, haga clic en el menú desplegable situado en la parte superior y seleccione el modelo descargado GPT-3.

Ahora puede comenzar a chatear con el modelo GPT-3 escribiendo sus mensajes en el campo de entrada situado en la parte inferior de la ventana del chat.

El modelo GPT-3 procesará sus mensajes y proporcionará respuestas en base a su entrenamiento. Tenga en cuenta que el tiempo de respuesta puede variar dependiendo de la hardware de su sistema y el tamaño del modelo descargado.

Conclusión

Instalando LM Studio en su sistema Linux utilizando el formato AppImage, puede descargar, instalar y ejecutar fácilmente grandes modelos de lenguaje locales sin dependencia de servicios basados en la nube.

Esto le brinda un mayor control sobre sus datos y privacidad mientras aún disfruta de los beneficios de los modelos de IA avanzados. Recuerde respetar los derechos de propiedad intelectual y adherirse a los términos de uso para los LLMs que descargue y ejecute usando LM Studio.