LM Studio ist eine benutzerfreundliche Desktop-Anwendung, die es Ihnen ermöglicht, große Sprachmodelle (LLMs) lokal auf Ihrem Linux-Rechner herunterzuladen, zu installieren und auszuführen.

Mit LM Studio können Sie sich von den Einschränkungen und Datenschutzbedenken befreien, die mit cloudbasierten KI-Modellen verbunden sind, während Sie weiterhin eine vertraute ChatGPT-ähnliche Oberfläche genießen.

In diesem Artikel führen wir Ihnen durch die Installation von LM Studio auf Linux mit dem AppImage-Format und geben ein Beispiel für die lokale Ausführung eines spezifischen LLM-Modells.

Systemanforderungen

Die minimalen Hardware- und Softwareanforderungen für die Ausführung von LM Studio auf Linux sind:

- Ein dedizierter NVIDIA- oder AMD-Grafikadapter mit mindestens 8 GB VRAM.

- Ein Prozessor, der mit AVX2 kompatibel ist, und mindestens 16 GB RAM sind erforderlich.

Installation von LM Studio unter Linux

Um zu beginnen, müssen Sie die neueste LM Studio AppImage von der offiziellen Website oder dem Repository herunterladen.

Sobald die AppImage heruntergeladen ist, müssen Sie sie ausführbar machen und den Inhalt der AppImage extrahieren, die sich in einem Verzeichnis namens squashfs-root entpackt.

chmod u+x LM_Studio-*.AppImage ./LM_Studio-*.AppImage --appimage-extract

Navigieren Sie nun zu dem extrahierten squashfs-root-Verzeichnis und setzen Sie die entsprechenden Berechtigungen für die Datei chrome-sandbox fest, die eine Hilfsbinärdatei ist, die die Anwendung benötigt, um sicher auszuführen.

cd squashfs-root sudo chown root:root chrome-sandbox sudo chmod 4755 chrome-sandbox

Nun kannst du die LM Studio-Anwendung direkt aus den extrahierten Dateien ausführen.

./lm-studio

Das ist alles! LM Studio ist nun auf deinem Linux-System installiert und du kannst beginnen, es zu nutzen, um lokale LLMs zu erkunden und zu starten.

Lokale Sprachmodelle auf Linux ausführen

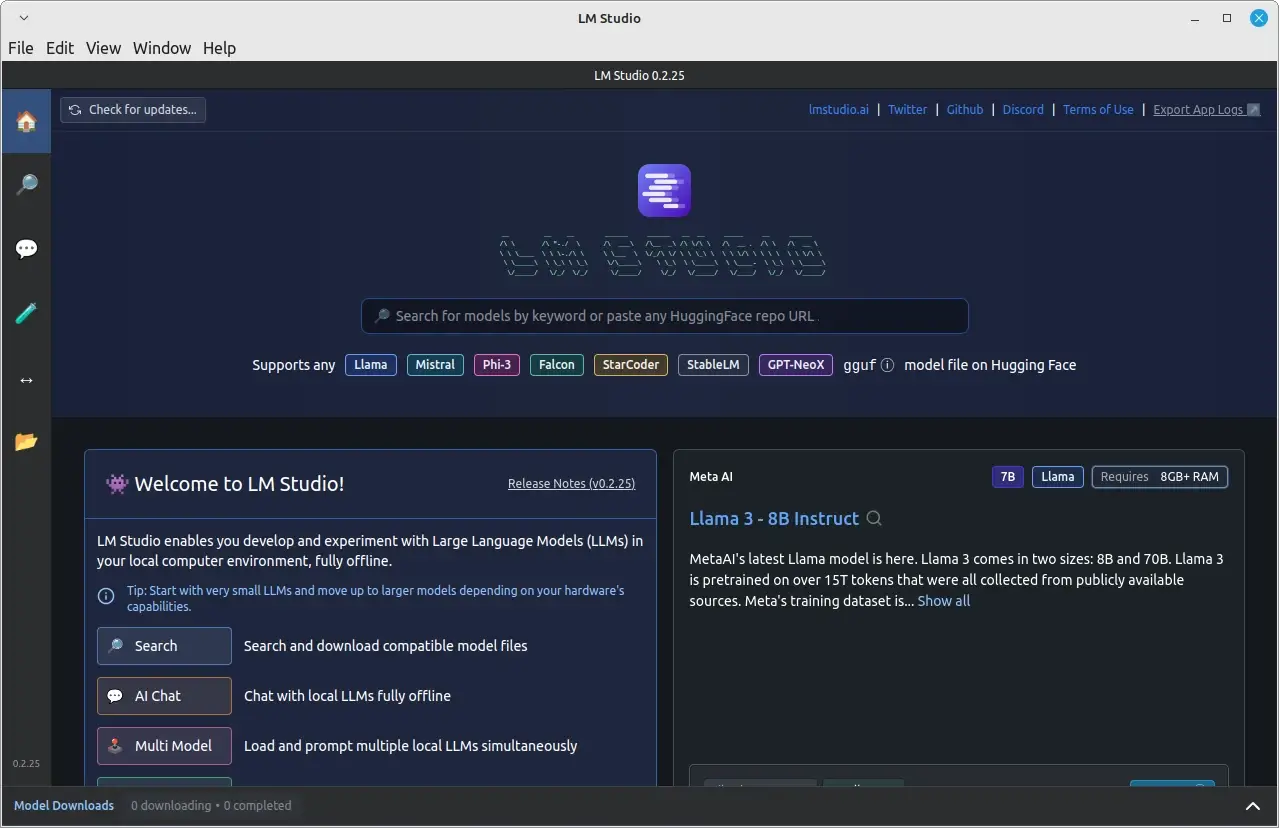

Nach erfolgreicher Installation und Ausführung von LM Studio kannst du beginnen, es zu verwenden, um Sprachmodelle lokal zu betreiben.

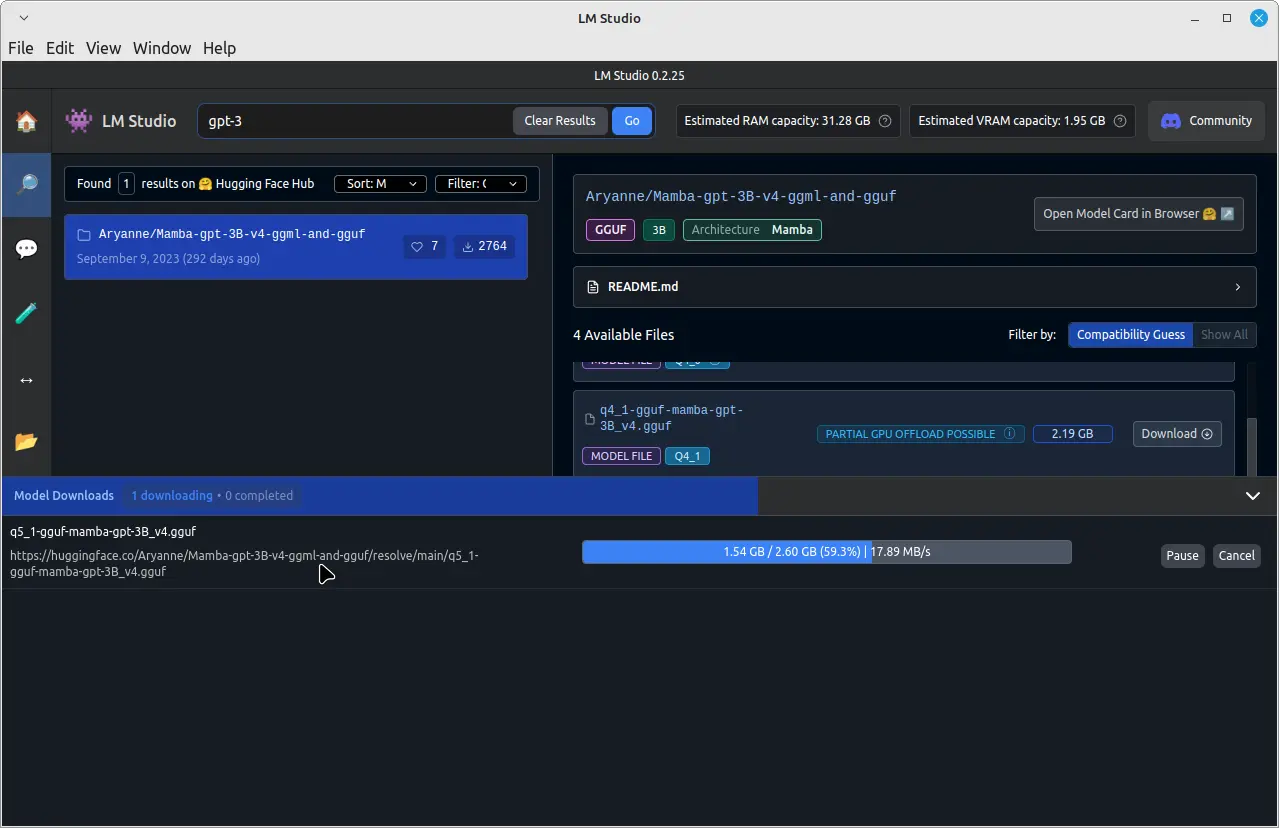

Zum Beispiel, um ein bereits trainiertes Sprachmodell namens GPT-3 zu betreiben, klicke oben in der Suchleiste auf die Suche und tippe “GPT-3” ein und lade es herunter.

Sobald der Download abgeschlossen ist, klicke im linken Bereich auf die Registerkarte “Chat“. Klicke in der Registerkarte “Chat” oben auf das Dropdown-Menü und wähle das heruntergeladene GPT-3-Modell aus.

Du kannst nun mit dem GPT-3-Modell chatten, indem du deine Nachrichten im Eingabefeld unten im Chatfenster tippst.

Das GPT-3-Modell verarbeitet deine Nachrichten und liefert Antworten auf der Basis seiner Ausbildung. Bedenke, dass die Antwortzeit von deiner Systemhardware und der Größe des heruntergeladenen Modells abhängen kann.

Schlussfazit

Durch die Installation von LM Studio auf deinem Linux-System im AppImage-Format kannst du leicht lokale Sprachmodelle herunterladen, installieren und lokal betreiben, ohne von cloudbasierten Diensten abhängig zu sein.

Dadurch haben Sie eine größere Kontrolle über Ihre Daten und Privatsphäre, während Sie immer noch die Vorteile fortschrittlicher AI-Modelle genießen. Denken Sie immer daran, die geistigen Eigentumsrechte zu respektieren und die Nutzungsbedingungen für die LLMs einzuhalten, die Sie herunterladen und mit LM Studio ausführen.